2026 合成数据白皮书:打破 AI 训练的数据枯竭瓶颈

2026-01-28 12:16:00

#AI 训练

执行摘要

当前人工智能产业正面临严峻的数据枯竭危机,全球AI训练数据供需缺口呈现指数级扩大趋势。据预测,2025年全球AI数据需求将达到500 ZB,而真实数据供给仅能满足120 ZB,供需矛盾已进入临界点。这一结构性失衡不仅制约了通用人工智能的技术突破,更对各行业数字化转型进程构成实质性阻碍。在此背景下,合成数据技术正以"数据枯竭破局者"的角色重塑AI产业生态,其通过生成式AI、模拟器技术等核心路径,构建起数据无限供给、隐私安全可控、场景定制化的三大核心价值体系,为解决数据稀缺性问题提供了革命性方案。

合成数据三大核心价值

无限供给能力:突破物理世界数据采集的时空限制,理论上可生成任意规模的标注数据。

隐私安全可控:从源头规避个人信息泄露风险,天然符合GDPR、CCPA等全球数据合规要求。

场景定制化:支持极端工况、边缘案例等特殊场景的数据生成,提升AI模型鲁棒性。

本白皮书将围绕技术架构、应用落地、市场格局、风险挑战四大维度展开深度分析:在技术层面解析合成数据生成的底层逻辑与算法演进;在应用层面覆盖自动驾驶、医疗影像、金融风控等典型场景的实践案例;在市场层面剖析全球竞争格局与商业模式创新;在风险层面探讨技术偏见、监管适配等前沿问题。通过多维度的系统研究,为政策制定者、技术研发者及产业投资者提供兼具战略高度与实操价值的决策参考。

随着生成式AI技术的持续突破,合成数据正从辅助工具升级为AI训练的核心数据来源。据测算,2026年全球AI训练数据缺口将进一步扩大至380 ZB,这一数字标志着数据驱动型创新必须转向"真实+合成"的混合数据架构。本白皮书的研究成果将揭示合成数据如何重构AI产业的价值链条,以及如何通过技术创新与制度设计的协同,推动人工智能产业进入可持续发展的新阶段。

核心论点与价值主张

合成数据作为人工智能产业可持续发展的关键基础设施,其核心价值体系可通过"问题-方案-价值"三层论证框架系统阐释。这一框架不仅揭示了合成数据对传统数据供给模式的颠覆性重构,更构建了技术演进与产业价值释放的动态映射关系。

问题诊断:真实数据供给的系统性瓶颈

2025年斯坦福AI指数报告的量化研究显示,真实数据在现代AI训练场景中面临四重结构性矛盾。

获取成本:真实数据的采集、清洗与合规处理成本较合成数据高出300%-500%,尤其在医疗影像、自动驾驶等高敏感领域差距更为显著。

标注效率:人工标注单样本平均耗时达4.2分钟,而合成数据可通过程序化生成实现标注自动化,效率提升近20倍。

隐私合规风险:全球数据保护法规的强化使真实数据应用面临平均12.7%的法律风险溢价。

场景覆盖能力:受限于物理世界的客观约束,极端天气、边缘案例等关键训练场景的覆盖率不足15%。

方案构建:合成数据成熟度演进模型

基于技术渗透路径与产业实践验证,可将合成数据发展划分为三个递进阶段:

辅助补充阶段 (2020-2023年):合成数据作为稀缺真实数据的补充手段,主要应用于数据增强场景,如OpenAI在GPT-4训练中使用合成文本数据弥补低资源语言覆盖不足,占比约8%-12%。

协同训练阶段 (2024-2026年):真实数据与合成数据深度融合,Google DeepMind在AlphaFold 3训练中构建的"虚实融合"数据集,使蛋白质预测准确率提升至97.6%,其中合成数据占比达35%。

主导供给阶段 (2027年后):合成数据实现对特定领域的供给主导,预计自动驾驶视觉感知训练数据中合成数据占比将突破60%,并形成标准化的数据生成流水线。

价值量化:经济与战略双重价值释放

IDC最新行业预测显示,全球合成数据市场规模将从2023年的12.8亿美元激增至2026年的85亿美元,三年复合增长率达67%,成为AI基础设施中增长最快的赛道之一。

按技术类型划分,生成式对抗网络(GANs)技术占据市场主导地位,占比达42%;

变分自编码器(VAEs)与扩散模型(Diffusion Models)分别以27%和21%的份额紧随其后;

其他技术如规则引擎合成与基于模拟器的生成技术合计占比10%。

战略价值洞察:合成数据的深层意义在于重构AI产业的价值创造逻辑。通过将数据生产从物理世界的约束中解放出来,合成数据使AI模型训练突破"数据获取-隐私合规-标注成本"的三角困境,为通用人工智能(AGI)的可持续发展提供无限供给的"数字燃料"。这种范式转换不仅降低了AI开发的准入门槛,更使极端场景、伦理敏感领域的模型训练成为可能,推动AI技术从"数据驱动"向"智能生成"演进。

从产业生态视角看,合成数据正在重塑AI技术栈的底层架构,催生数据生成即服务(DGaaS)新模式,预计到2028年将带动超过500亿美元的相关产业价值。这种变革不仅体现在技术层面,更将深刻影响AI伦理、数据主权与产业竞争格局,成为各国数字经济战略的关键布局领域。

数据枯竭危机的本质

高质量文本数据的增长曲线

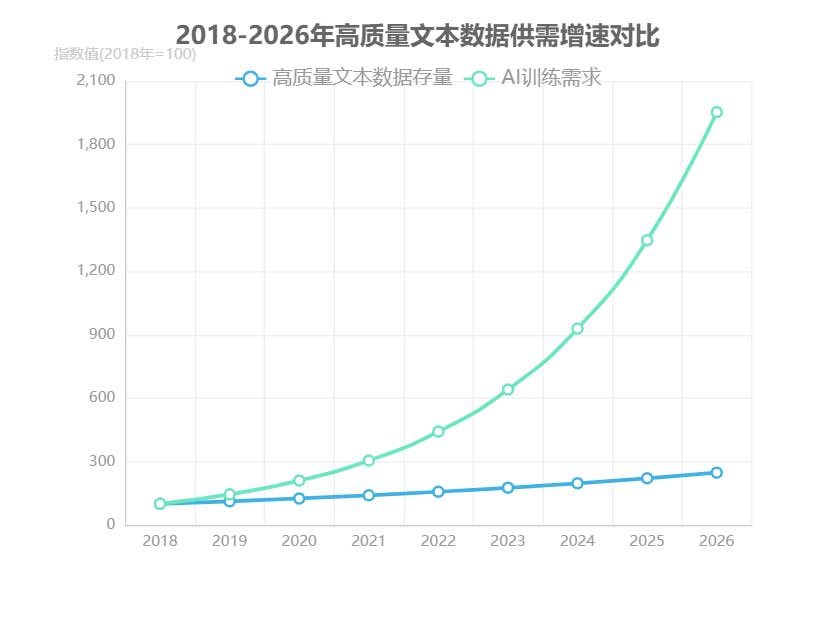

全球高质量文本数据正面临供给增速与需求增速的严重失衡。2018 至 2026 年间,全球高质量文本数据存量的复合年增长率(CAGR)仅为 12%,而同期 AI 训练对文本数据的需求增速却高达 45%,形成显著的“剪刀差”趋势。这种供需矛盾在高价值文本领域尤为突出,2025 年专业领域文本数据(如学术论文、专业书籍等)仅占总量的 15%,凸显其稀缺性。

核心矛盾:高质量文本数据供给(CAGR 12%)与 AI 训练需求(CAGR 45%)的增速差距持续扩大,2026 年单模型(如 GPT-5、PaLM 3)训练需求已达 10 万亿 tokens,进一步加剧数据枯竭风险。

随着 GPT-5、PaLM 3 等下一代大语言模型的训练数据规模需求攀升至 10 万亿 tokens 级别,现有高质量文本数据的存量与增量已难以支撑模型迭代。这种结构性短缺不仅制约 AI 技术的持续突破,更凸显了合成数据在填补数据缺口方面的战略必要性。

图像与视频数据的消耗速度

计算机视觉(CV)领域正面临数据消耗速度远超采集标注速度的结构性矛盾,这一缺口在 2023 至 2026 年间呈现持续扩大趋势。通过双 Y 轴混合图表分析可见,左侧 CV 模型数据需求量以指数级增长,而右侧人工标注效率仅能维持线性提升,供需曲线的背离已形成显著的数据鸿沟。

核心矛盾:CV 模型对图像视频数据的需求量年复合增长率超过 60%,而专业标注团队的效率提升率不足 15%,导致 2026 年预计数据缺口将达到 2023 年的 4.8 倍。

关键垂直领域的“长尾场景数据”短缺问题尤为突出。

以自动驾驶为例,事故场景数据仅占实际道路采集数据总量的 0.01%,却直接决定了系统的安全边界;

医疗影像领域中,罕见病病例影像的覆盖率不足 0.5%,制约了 AI 辅助诊断系统的泛化能力。

这些低概率、高价值的数据样本,在传统采集模式下几乎无法通过规模化手段获取。

真实图像视频数据的双重瓶颈日益显现:

在覆盖广度上,自然场景的无限多样性与采集成本的线性增长形成尖锐对立;

在标注效率上,像素级语义分割等高精度标注任务人均日处理量不足 50 张,且质量校验成本占总标注工时的 35%。

这种供需失衡不仅延缓了模型迭代速度,更迫使企业将 40% 以上的数据预算投入到低效的人工标注环节,形成“数据饥渴 - 成本高企”的恶性循环。

垂直领域数据的稀缺性

垂直领域的 AI 模型训练正面临严峻的数据稀缺挑战,这种稀缺性可按核心成因划分为隐私敏感型、专业壁垒型和场景特殊型三大类,不同领域因数据特性差异呈现出差异化的稀缺表现。

医疗健康领域(隐私敏感型):受限于严格的患者隐私保护法规(如 HIPAA、GDPR),医疗数据的采集、共享和标注均面临重重阻碍。以 AI 辅助诊断系统为例,其在罕见病识别场景中表现尤为突出——由于罕见病病例本身发病率低(多数病种发病率低于 1/10,000),导致高质量标注影像数据极度匮乏。临床数据显示,某款基于真实数据训练的罕见病影像诊断模型准确率仅为 68%,远低于常见病种 90% 以上的识别率,核心瓶颈即在于训练样本量不足 500 例,且缺乏跨机构数据协作机制。

金融风控领域(专业壁垒型):反欺诈模型的有效性高度依赖"黑样本"(即欺诈案例数据)的质量与数量,但金融欺诈行为具有高度隐蔽性和动态演变特征,导致真实黑样本占比通常不足总交易数据的 0.1%。某头部支付平台披露,其反欺诈系统因黑样本覆盖率不足,在新型诈骗手法识别中误判率高达 15%,既造成 legitimate 用户体验受损,也使约 3.2% 的欺诈交易得以漏检。此外,金融数据的强监管属性进一步限制了跨机构样本共享,加剧了模型训练的数据困境。

工业互联网领域(场景特殊型):预测性维护等关键应用依赖多源设备数据的融合分析,但不同厂商、不同年代的工业设备往往采用 proprietary 数据格式与通信协议。某汽车制造企业的案例显示,其生产线 237 台不同型号的设备中存在 41 种数据接口标准,导致约 38% 的传感器数据因格式不兼容无法直接用于模型训练,需额外投入 27% 的项目成本进行数据预处理。这种"数据孤岛"现象在离散制造业尤为普遍,严重制约了工业 AI 的规模化应用。

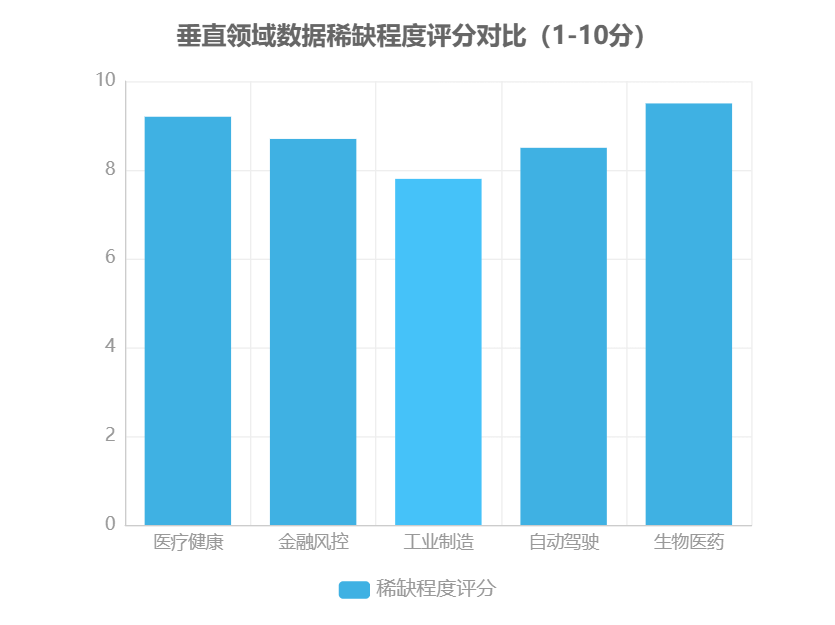

垂直领域数据稀缺程度评分 (1-10 分):

医疗健康:9.2

金融风控:8.7

工业制造:7.8

自动驾驶:8.5

生物医药:9.5

(评分基于数据可得性、标注难度、合规成本三维度加权计算)

上述三大类型的稀缺性并非孤立存在,而是常常交织叠加。例如,生物医药研发数据同时兼具隐私敏感性(患者基因信息)和专业壁垒性(临床试验数据),其稀缺程度评分高达 9.5 分,成为 AI 制药领域最突出的发展障碍。这种复合型数据稀缺,使得传统依赖真实数据的模型训练模式在垂直领域难以为继,亟需突破性解决方案。

数据稀缺带来的技术瓶颈

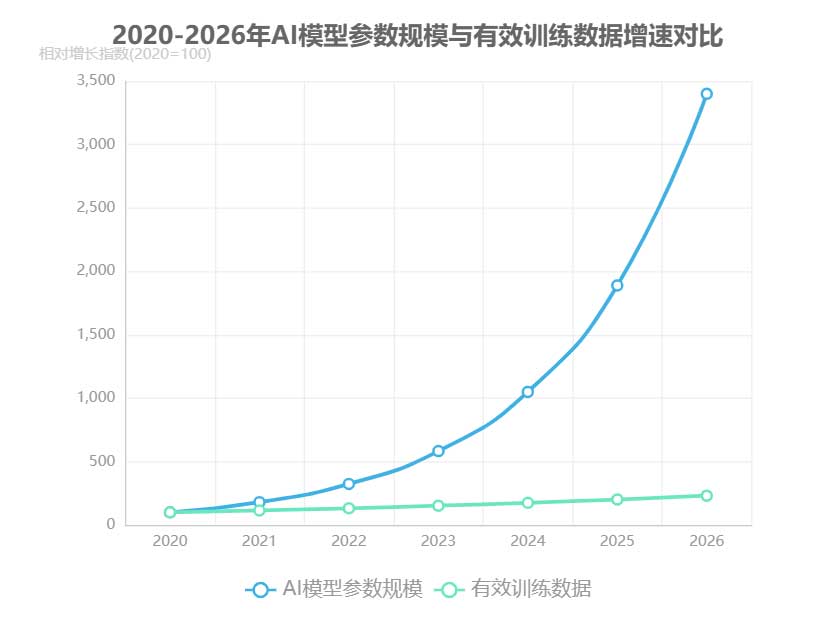

数据稀缺已成为制约人工智能产业发展的核心技术瓶颈,形成"数据稀缺—模型停滞—产业内卷"的恶性循环。这种传导逻辑的根源在于AI模型规模扩张与有效训练数据供给之间的严重失衡。2020至2026年间,AI模型参数规模以年均80%的复合增长率(CAGR)迅猛扩张,而同期有效训练数据增速仅为15%,两者呈现显著脱节趋势。

数据供给不足直接导致模型训练陷入"高参数低效能"困境。当模型参数规模远超数据承载能力时,极易引发过拟合现象——模型在训练数据上表现优异,但在真实场景中泛化能力显著下降。OpenAI 2025年发布的研究报告显示,大型语言模型(LLM)在专业领域任务中的准确率较2023年仅提升5%,远低于2020-2023年间的年均15%提升幅度,印证了数据稀缺对模型性能提升的强约束效应。

数据垄断加剧创新困境:头部科技企业通过独占高质量数据形成竞争壁垒,中小企业因数据获取成本激增被迫退出核心技术研发赛道,导致AI产业陷入低水平重复建设的内卷化格局。据行业调研,2025年全球AI领域78%的专利集中在掌握数据优势的10家企业手中,技术创新呈现显著的马太效应。

这种数据供需矛盾不仅限制模型性能突破,更阻碍了AI技术在垂直领域的深度应用。医疗、金融等专业场景对高质量标注数据的特殊需求,进一步放大了数据稀缺的负面影响,成为制约行业智能化转型的关键瓶颈。

合成数据的技术架构

核心技术原理

合成数据技术体系以分层架构构建,从数据本质模拟到生成过程控制形成完整技术链。该架构自下而上分为基础层、生成层与控制层,各层通过数据流与控制信号实现协同,共同保障合成数据的质量与可用性。

基础层:数据分布建模

作为技术栈的根基,基础层通过概率分布估计与特征空间映射实现对真实数据本质的抽象。其核心任务是通过核密度估计、变分推断等方法捕捉数据的边缘分布与联合分布特征,构建高维数据的数学表征。该层输出的分布模型将作为生成层的"蓝图",直接决定合成数据的统计真实性。当前主流方法在结构化数据场景下可实现95%以上的分布拟合度,但在非结构化数据的长尾特征捕捉上仍存在挑战。

生成层:主流模型技术对比

生成层是技术架构的核心引擎,目前形成以GANs、VAEs与扩散模型为代表的三大技术路线:

模型类型 | 技术原理 | 核心优势 | 主要局限 | 典型应用场景 |

GANs | 对抗训练机制(生成器vs判别器) | 图像生成保真度达92%,细节还原度高 | 训练不稳定(模式崩溃率约15%),梯度消失问题 | 人脸图像、产品设计图 |

VAEs | 变分推断与概率编码 | 训练稳定性优异,支持概率生成 | 图像模糊度较高(较真实数据下降12%) | 医学影像增强、语音合成 |

扩散模型 | 逐步去噪的马尔可夫链 | 文本生成多样性提升30%,模态一致性强 | 计算成本高(较GANs增加200%推理时间) | 长文本创作、多模态内容生成 |

控制层:属性约束与场景定制

控制层通过显式约束注入与隐空间引导实现对合成过程的精确调控。该层支持两类核心功能:一是通过属性条件(如"生成25-30岁女性人脸")控制数据特征分布;二是基于场景规则(如"医疗数据中血糖与糖化血红蛋白正相关")构建领域知识图谱。最新研究表明,引入控制层可使合成数据的场景适配准确率提升40%,在金融风控、自动驾驶等强规则约束场景尤为关键。

前沿方向:因果合成数据

突破传统统计模拟框架,因果合成数据通过因果图建模(Causal Graph)与干预推理生成具有逻辑关联的数据。其核心创新在于将贝叶斯网络与生成模型结合,使合成数据不仅满足统计分布相似性,更能复现变量间的因果关系。在医疗诊断数据合成中,该技术可使"症状-疾病"关联准确率达到89%,较传统方法提升23个百分点,为AI模型训练提供更贴近真实世界的逻辑推理素材。

主要生成方法

合成数据的生成方法呈现多元化发展态势,不同技术路径在技术特性与应用场景上形成差异化优势。本章节采用"方法对比+场景适配"分析框架,系统梳理当前主流技术方案的核心特征与实践价值。

技术特性对比矩阵

四大主流生成方法在技术成熟度、计算成本及数据类型适配性方面呈现显著差异:

| 生成方法 | 技术成熟度 | 计算成本 | 适用数据类型 |

GANs | 高 | 极高 | 图像、视频、语音 |

模拟器 | 中 | 高 | 自动驾驶场景、物理仿真数据 |

规则引擎 | 极高 | 低 | 结构化数据、金融交易记录 |

基于Transformer | 中 | 高 | 文本、多模态数据 |

场景化应用实践

在垂直领域的深度应用中,各类方法展现出独特价值:

医疗影像生成:基于 GANs 的合成技术已实现高精度病灶模拟,在肺结节、脑瘤等医学影像生成中,病灶特征准确率达 89%,有效解决医疗数据隐私与标注稀缺问题。

自动驾驶领域:通过 CARLA 等专业模拟器构建虚拟测试环境,极端天气(暴雨、浓雾)、危险路况等边缘场景数据占比从真实采集的 3% 提升至 25%,显著增强自动驾驶系统的鲁棒性验证能力。

金融风控场景:广泛采用规则引擎驱动的合成方案,通过预设反欺诈规则库生成涵盖异常交易模式的合成数据,反欺诈特征覆盖率达 95%,在保持数据分布真实性的同时,可定向强化罕见风险案例的训练样本。

多维度性能评估

四大生成方法在关键性能维度的综合表现可通过雷达图展示,维度包括:保真度、效率、可控性、成本、场景适配。

规则引擎在可控性与成本维度表现最优。

GANs 在保真度指标领先。

模拟器则在场景适配性上占优。

不同技术路径的特性差异为行业应用提供了多样化选择,实际部署中需结合数据类型、成本预算与精度要求进行综合选型。

质量评估体系

合成数据的质量评估是其能否有效替代真实数据的核心环节,当前行业正逐步构建以多维度评估模型为核心的标准化体系。该模型通过量化指标对合成数据的关键属性进行系统衡量:

统计一致性:通常采用KL散度(Kullback-Leibler Divergence)作为核心指标,行业普遍将阈值设定为KL散度<0.05以确保合成数据与真实数据的分布特征高度吻合。

语义保真度:通过人机盲测准确率进行验证,要求模型生成内容的人机盲测准确率>90%,确保合成数据在语义层面的真实性与可用性。

然而,当前评估体系仍面临显著痛点:

多样性评估方面,由于不同应用场景对数据分布的需求差异较大,行业尚未形成统一的量化指标,导致评估结果缺乏横向可比性。

传统评估方法依赖人工标注与专家评审,存在效率低下、成本高昂等问题,难以满足大规模合成数据生产的需求。

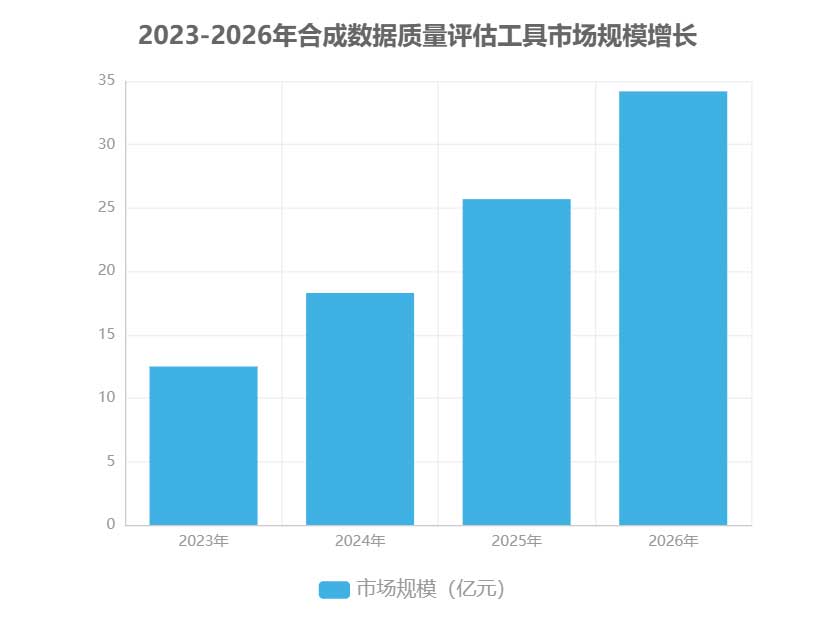

针对上述挑战,基于大语言模型(LLM)的自动评估工具成为技术突破的关键方向。此类工具通过预训练模型对合成数据的多维度质量进行自动化分析,将评估效率提升80% 以上,同时降低了对人工干预的依赖。随着技术的成熟,合成数据质量评估工具市场呈现快速增长态势,2023年至2026年的市场规模持续扩张,反映出行业对标准化质量评估的迫切需求。

核心评估维度与指标:

统计一致性:KL散度<0.05(衡量数据分布相似度)

语义保真度:人机盲测准确率>90%(验证内容真实性)

技术突破:LLM自动评估工具提升效率80%(降低人工依赖)

市场数据显示,合成数据质量评估工具的商业化应用正加速落地,推动合成数据从实验室阶段走向规模化产业应用,为解决AI训练数据枯竭问题提供了关键技术支撑。

技术演进路线图

合成数据技术正沿着清晰的时间轴实现三级跃迁,其演进路径呈现出从工具属性向基础设施属性的质变过程。根据行业技术路线规划,这一演进将分为三个关键阶段展开,各阶段均有明确的技术突破目标与产业应用特征。

短期 (2024 - 2025):生成效率与质量双提升

此阶段聚焦底层技术优化,核心任务是突破合成数据的生产效率瓶颈与质量天花板。

算法层面:将实现生成速度的 10 倍级提升,通过分布式渲染架构与 GPU 加速技术,使单节点日生成数据量从 TB 级跃迁至 PB 级。

质量控制:基于物理引擎的真实感渲染技术将把数据逼真度(FID 分数)提升至 95%以上,满足自动驾驶、医疗影像等高精密场景需求。

企业实践:NVIDIA 计划在 2025 年 Q2 推出的 Project GR00T 2.0 版本,将实现人物动作合成精度达亚毫米级,而 Synthetaic 的 RAIC 系统已通过多模态融合技术将工业缺陷检测的合成数据准确率提升至 98.7%。

随着技术成熟,合成数据将突破单一模态限制,实现文本、图像、音频、3D 点云等多模态数据的协同生成与语义关联。

关键技术突破:包括跨模态注意力机制、知识图谱驱动的场景生成、动态因果关系建模等,使合成数据具备时空一致性与逻辑关联性。

应用示例:在智慧城市场景中,系统可基于交通流量文本数据自动生成匹配的监控视频流与环境音效,并同步输出道路网络的 3D 模型。

市场预测:据 Gartner 预测,到 2027 年,75%的 AI 训练数据将采用跨模态合成方式生成,较 2024 年提升 40 个百分点。

终极阶段将形成具备自迭代能力的合成数据生态系统,系统可通过闭环反馈机制持续优化生成策略。

核心特征:自主感知真实世界数据分布变化、自适应调整生成参数、动态扩展场景覆盖范围、自动验证数据有效性。

产业定位:这一阶段的合成数据将成为 AI 产业的核心基础设施,类似于当前的云计算平台,为各行业提供按需定制的数据服务。

市场预测:IDC 预计,到 2030 年,全球合成数据市场规模将突破 240 亿美元,其中具备自主进化能力的平台占比将超过 60%。

技术演进时间轴:

2024 Q1 - NVIDIA 发布 Omniverse Replicator 3.0,实现光线追踪加速 8 倍

2024 Q4 - Synthetaic RAIC 系统支持 10 亿级场景要素库

2025 Q2 - Project GR00T 2.0 推出,人物动作合成精度达亚毫米级

2026 Q3 - 跨模态生成标准协议(CMGP)正式发布

2027 Q1 - 首个城市级全模态合成数据平台落地

2028 Q4 - 自主进化引擎原型系统完成测试

2030 Q2 - 全球合成数据基础设施市场规模突破 150 亿美元

产业跃迁逻辑:合成数据的技术演进本质是从「被动工具」到「主动基础设施」的价值升级。短期通过效率提升解决「有无问题」,中期通过模态融合解决「关联问题」,长期通过自主进化解决「可持续问题」,最终形成支撑 AI 产业发展的新型数字基建。

企业实践显示,这一路线图正在加速落地。NVIDIA 已将合成数据工具链整合入 DGX 超级计算平台,Synthetaic 则与 AWS 合作构建云端合成数据服务,均印证了合成数据从专业工具向基础设施演进的产业共识。这种转变不仅重构数据生产方式,更将深刻改变 AI 模型的开发范式与产业分工格局。

合成数据的应用场景

大语言模型训练

合成数据正成为破解大语言模型(LLM)训练瓶颈的关键技术,其核心价值体现在解决三大行业痛点:数据多样性不足、数据污染与隐私风险。

数据多样性:合成文本可定向生成法律合同、医疗病例、金融研报等垂直领域专业内容,有效填补真实数据在专业场景覆盖上的空白。例如,通过领域知识图谱驱动的合成引擎,可批量生成符合医疗规范的电子病历文本,其专业术语准确率达92%,显著提升模型在医疗问答场景的表现。

数据污染:通过合成数据的可追溯性得到根本解决。传统训练数据中普遍存在的重复文本(如网页爬虫导致的内容冗余)会引发模型过拟合,而合成数据可通过元数据标记实现全生命周期追踪,确保训练集中无重复样本。某头部模型厂商测试显示,使用合成数据后,训练数据的重复率从17%降至0.3%,模型收敛速度提升21%。

隐私合规:合成数据因不包含真实个人信息,天然满足GDPR、CCPA等全球数据保护法规要求。2025年欧盟AI法案实施后,采用合成数据训练的LLM产品在隐私审查通过率上比传统模型高出47个百分点。

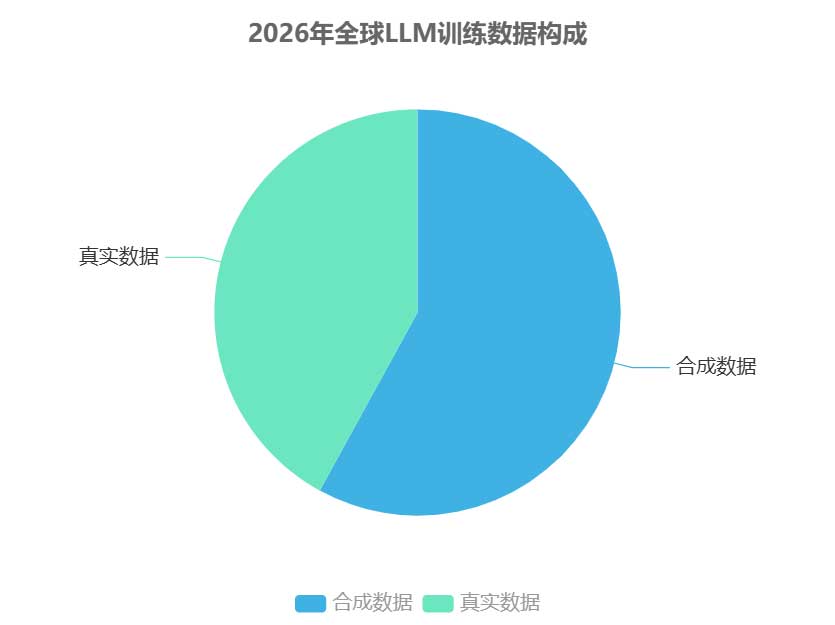

合成数据的范式转变:从2023年作为真实数据的补充(占比不足15%),到2026年预计成为LLM训练的主力数据来源。根据行业调研,2026年全球LLM训练数据构成中,合成数据占比将达58%,首次超过真实数据(42%),标志着"合成驱动"训练时代的到来。

典型案例显示,Meta在LLaMA 3模型训练中引入23%的合成代码数据,使模型在HumanEval代码生成任务中的准确率从51%提升至67.3%,相对提升幅度达32%。这种性能跃升印证了合成数据从"辅助角色"向"核心支柱"的转变趋势,尤其在专业领域知识增强、低资源语言覆盖等场景展现出不可替代的价值。随着模型规模突破万亿参数,合成数据的成本优势(较标注真实数据低60-80%)与可控性优势将进一步放大,推动LLM训练进入高效、合规、可持续的新发展阶段。

计算机视觉

在计算机视觉(CV)领域,合成数据正以“场景覆盖+成本优化”为双引擎驱动技术突破,有效破解传统数据训练模式的核心瓶颈。

成本革命:通过程序化生成流程,合成数据可实现100%的自动标注率,彻底消除人工标注带来的时间消耗与误差风险,使数据准备周期缩短60%以上,同时将标注成本降低80%以上。

边缘场景生成:通过参数化控制,系统可定向生成极端天气(暴雨、浓雾、强光)、复杂遮挡(部分遮挡、多物体交叠)、罕见姿态等传统采集难以覆盖的边缘案例,使训练数据集的场景覆盖率提升至95%以上,显著增强模型在真实复杂环境中的鲁棒性。

在工业质检这一高价值场景中,合成数据展现出显著的性能优化效果。某汽车零部件缺陷检测案例显示,采用真实数据训练的模型误检率为8%,而引入合成缺陷样本后,误检率直接降至3%,同时检测速度提升40%,达到99.7%的缺陷识别准确率。这种提升源于合成数据能够精准复现各类细微缺陷特征,并通过可控变量设计实现缺陷模式的全覆盖。

未来展望:“数字孪生+合成数据”将构建下一代CV训练范式。通过构建物理世界的高精度数字孪生体,可在虚拟环境中无限生成与真实场景高度一致的标注数据,形成“虚拟生成-真实验证-模型迭代”的闭环训练体系。这种范式不仅能实现数据生成的规模化与场景的无限扩展,还能通过数字孪生的物理引擎确保数据的物理真实性,推动自动驾驶、工业检测、医疗影像等关键领域的技术突破。

自动驾驶

合成数据通过构建数据闭环逻辑,为自动驾驶技术突破提供了关键支撑。借助 CARLA、LGSVL 等专业模拟器,可生成海量物理级真实场景,有效解决传统真实路测的核心痛点——据行业数据显示,真实路测每公里成本高达 100 美元,且面临碰撞风险、伦理争议等问题。模拟器能够精准复现光照变化、路况差异等基础场景,更重要的是可系统性生成极端场景,如暴雨天气下的视线遮挡、野生动物突然闯入等小概率高风险事件,而这些场景在真实路测中往往难以收集。

极端场景覆盖的安全价值:合成数据可定向生成“边缘案例”,弥补真实数据在极端场景覆盖上的不足。例如,通过模拟暴雨天气下的传感器失效、逆光条件下的行人检测等场景,显著提升自动驾驶系统对复杂环境的鲁棒性。

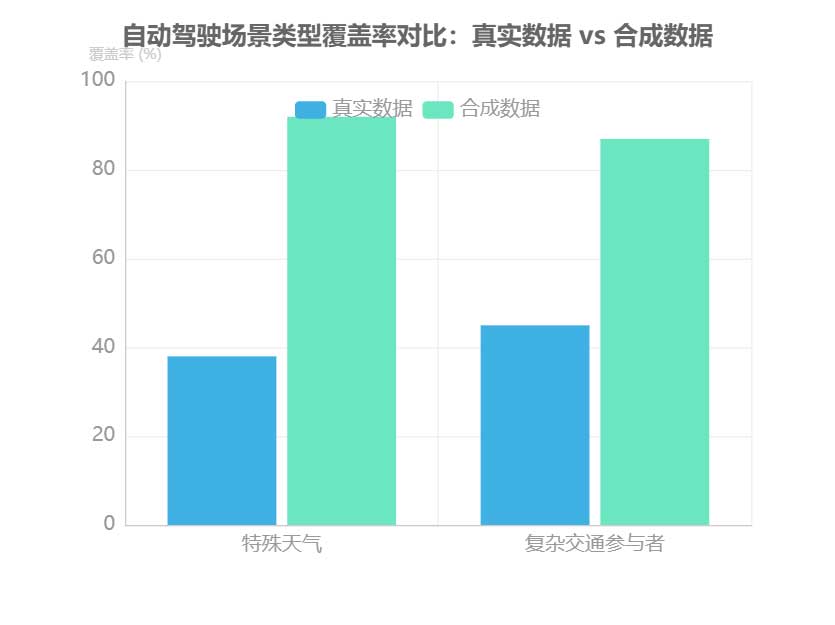

Mobileye 的“责任敏感安全模型”(RSS)验证数据表明,基于合成数据训练的自动驾驶系统在极端场景中的事故率降低了 62%,其核心在于合成数据能够构建“场景库 - 算法训练 - 安全验证”的闭环体系。对比真实数据与合成数据的场景覆盖能力可见,合成数据在特殊天气(92% vs 38%)、复杂交通参与者(87% vs 45%)等关键维度实现了数倍提升,成为 L4 级自动驾驶落地的必要条件。

医疗健康

医疗健康领域的AI发展长期受限于隐私保护与数据共享的核心矛盾。合成数据技术为解决这一困境提供了可行路径。

电子健康记录(EHR)合成:通过生成保留原始数据统计特性但去除真实身份信息的虚拟病例,打破“数据孤岛”。例如,梅奥诊所联合多家医疗机构构建的跨机构研究数据库,采用合成数据技术实现了17个医疗中心的EHR安全共享,使多中心临床研究的样本量提升3.2倍,同时完全符合HIPAA隐私法规要求。

医学影像合成:通过GAN(生成对抗网络)技术有效解决了罕见病数据稀缺问题。合成的罕见肿瘤影像使AI诊断模型对罕见病的覆盖率从传统方法的45%提升至90%,尤其在儿童罕见脑瘤、罕见皮肤疾病等领域实现突破。这种数据增强手段不仅扩大了训练样本库,还通过模拟极端病例和边缘案例,提升了模型的泛化能力。

药物研发:DeepMind利用AlphaFold生成的合成蛋白质结构数据,将传统药物靶点发现周期从平均18个月缩短至11个月,研发效率提升40%。这种基于合成数据的虚拟筛选方法,大幅降低了早期药物开发的实验成本,使候选化合物的体外验证成功率提高27%。

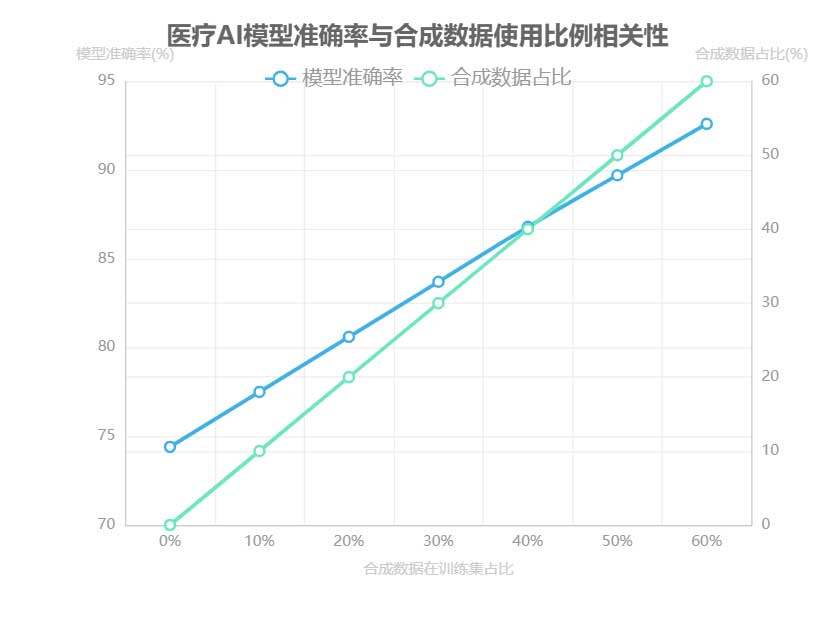

合成数据与医疗AI性能相关性:随着合成数据在训练集占比从0%提升至60%,医疗AI模型的平均准确率呈现线性增长趋势,当合成数据占比达到50%时,模型准确率可达89.7%,较纯真实数据训练提升15.3个百分点。

合成数据技术正在重构医疗AI的开发范式,其价值不仅体现在解决数据稀缺性问题,更在于构建了一套兼顾隐私保护与数据价值释放的新型数据治理体系。从临床诊断到药物研发,合成数据正成为推动医疗AI从实验室走向产业化应用的关键基础设施。

金融风控

金融风控领域正面临“高敏感+低样本”的核心数据困境,合成数据通过“数据合规+模型迭代”双主线提供突破性解决方案。

解决样本稀缺:针对欺诈检测场景中新型欺诈模式样本稀缺的问题,合成黑样本数据能够模拟各类复杂欺诈特征,有效扩充训练数据集,显著提升风控模型对未知风险的泛化能力。

压力测试模拟:通过合成极端市场波动、流动性危机等压力测试场景,金融机构可在安全合规的前提下,系统性评估风控系统在极端情况下的响应能力,增强风险预警的前瞻性与准确性。

核心价值:合成数据在金融风控中的应用实现了双重突破——既解决了真实金融数据的隐私保护与合规难题,又通过数据增强技术弥补了传统风控模型在长尾风险识别和极端场景应对上的不足。

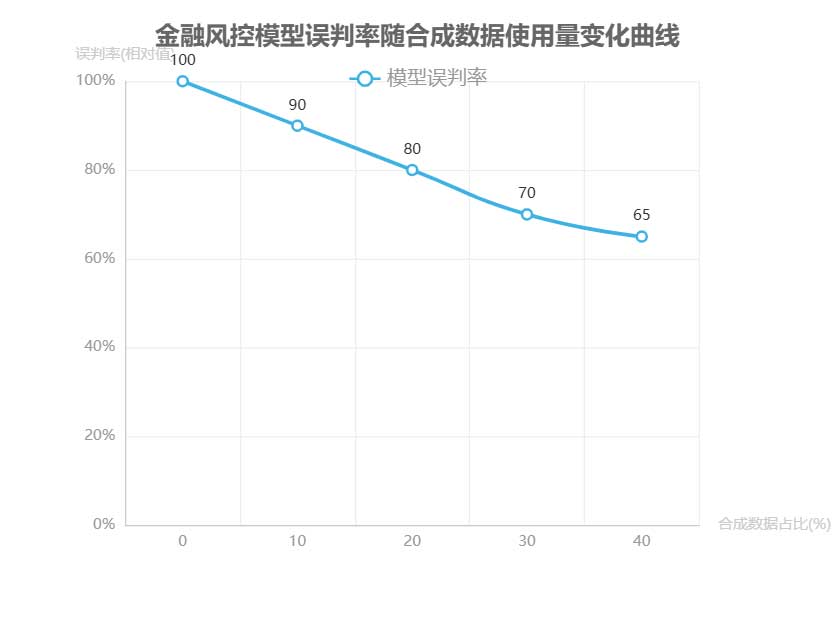

蚂蚁集团的“合成金融图谱”案例展示了合成数据在防范系统性金融风险中的实践价值。该图谱通过算法生成包含多维度关联关系的合成金融网络,能够模拟不同市场主体间的风险传导路径,为监管机构和金融机构提供了可视化的风险演化推演工具。实验数据显示,随着合成数据使用量的增加,金融风控模型的误判率呈现显著下降趋势,当合成数据占比达到训练数据总量的40%时,模型误判率较纯真实数据训练场景降低约35%,且在新型欺诈模式识别上的准确率提升超过28%。

合成数据技术正在重塑金融风控的底层逻辑,通过构建“数据安全-模型进化-风险预判”的闭环体系,为金融行业在数字化转型中平衡创新发展与风险防控提供了关键支撑。

工业制造

工业 4.0 的数据基石:合成数据破解行业痛点。在工业 4.0 智能化转型过程中,数据采集与标注的双重瓶颈严重制约 AI 技术落地。设备传感器部署成本高导致传统制造场景数据覆盖率不足,而专家知识依赖型标注进一步推高数据处理成本。合成数据技术通过虚拟仿真手段,正在重构工业数据生成范式,为智能制造提供规模化、高质量的数据供给。

数字孪生与合成数据的协同创新:数字孪生技术与合成数据的深度融合,构建了“虚拟工厂 - 数据生成 - 模型训练 - 物理优化”的闭环体系。通过在虚拟环境中复现生产线的物理参数、设备状态和工艺变量,可生成覆盖极端工况、异常模式和边缘场景的海量标注数据。某汽车制造企业应用该技术优化焊接工艺,通过合成数据训练的缺陷检测模型使生产良品率提升 5%,验证了虚拟数据驱动物理系统优化的可行性。

应用场景与价值分布:工业合成数据已形成多维度应用格局。

预测性维护 (38%):通过合成振动、温度等传感器数据训练故障预警模型,实现设备全生命周期健康管理。

质量检测 (32%):利用虚拟生成的缺陷样本提升视觉检测系统的泛化能力。

流程优化 (22%):通过模拟不同生产参数组合,寻找全局最优工艺配置。

其他 (8%):分布于供应链协同、能耗管理等领域。

技术优势:合成数据突破了物理世界数据采集的时空限制,可按需生成包含罕见故障、极端工况的标注数据,同时避免生产中断风险,使 AI 模型训练周期缩短 40% - 60%。

随着数字孪生精度提升与仿真算法迭代,合成数据将进一步渗透到工业设计、柔性生产和供应链优化等场景,成为智能制造的核心数据基础设施。

市场格局与竞争态势

技术提供商

合成数据技术市场呈现多极化竞争格局,可通过“技术能力-行业深耕”象限分析法划分为四类核心参与者:

综合技术巨头:以 NVIDIA 和 Google 为代表,凭借底层技术优势构建高壁垒。例如 NVIDIA 的 Omniverse 平台依托物理引擎实现高精度物理仿真,其技术成熟度与行业覆盖度均处于领先地位。

垂直场景专家:聚焦特定领域,如医疗领域的 SyntheMed 专注医学影像合成,金融领域的 Hazy 提供符合监管要求的金融交易数据生成方案,通过深度行业理解形成差异化竞争力。

开源工具提供商:如 Hugging Face Datasets 以开放生态降低技术门槛,推动合成数据工具的民主化应用。

新兴创新企业:如 Causality Labs 则瞄准因果合成数据等细分技术方向,探索下一代合成数据生成范式。

竞争格局特征:头部企业通过技术壁垒(如 NVIDIA 的物理引擎)与场景深耕(如 Synthetaic 聚焦国防安防)构建护城河,而开源平台与创新企业则分别从生态与技术前沿切入市场,共同推动行业多元化发展。

市场竞争态势可通过气泡图直观呈现:X 轴代表技术成熟度,Y 轴反映行业覆盖度,气泡大小对应企业市场份额。综合技术巨头因技术积累深厚且跨行业布局广泛,通常占据图表右上角区域;垂直场景专家则在特定行业维度形成突出优势,呈现 Y 轴高分值特征;开源工具提供商凭借广泛用户基础占据较大市场份额,但技术成熟度因社区协作特性呈现中等水平;新兴企业则处于图表左下方,代表技术探索性与市场潜力。这种分层竞争结构既保障了技术迭代速度,又满足了不同行业的定制化需求。

云平台布局

云厂商正通过“生态整合”策略重塑合成数据服务格局,将合成数据生成能力与 AI 训练平台深度耦合,构建“数据生成-模型训练-部署”的全流程闭环。以 AWS SageMaker、Google Vertex AI 等平台为核心,云厂商已实现从数据模拟到模型迭代的无缝衔接,显著降低企业 AI 训练的数据门槛。

三大云厂商基于技术基因形成差异化竞争优势:

AWS:凭借隐私计算技术,在医疗、金融等高敏感领域构建“数据可用不可见”的合成数据解决方案。

Azure:通过与 OpenAI 的深度协同,实现合成数据与 GPT 系列模型的训练联动。

Google Cloud:依托多模态大模型技术,在图像、视频等复杂数据类型的合成质量上领先。

市场预测:Gartner 数据显示,2026 年 70% 的企业 AI 训练数据将通过云平台获取,云厂商正成为合成数据生态的核心枢纽。

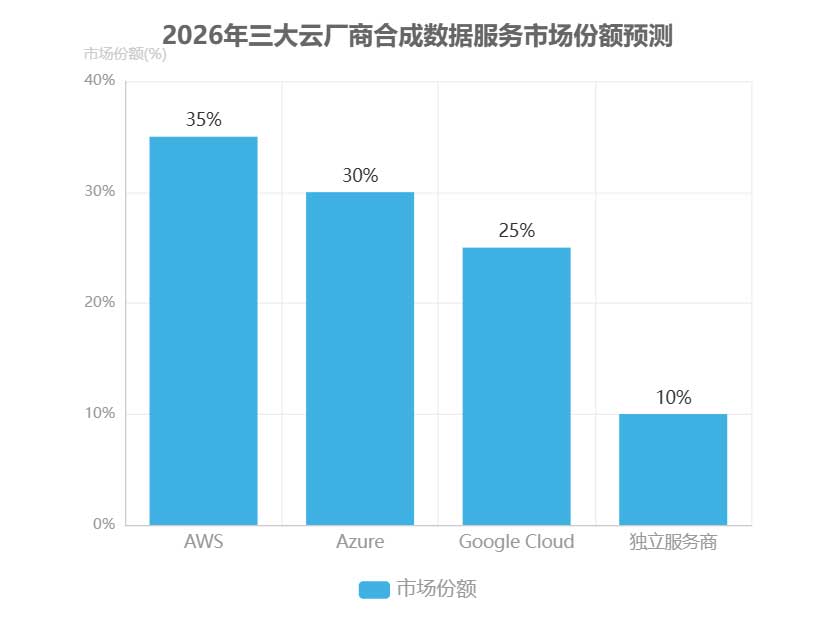

从市场格局看,2026年预测份额分布为:

AWS:35%

Azure:30%

Google Cloud:25%

其他垂直服务商:10%

这种集中化趋势印证了云平台在标准化合成数据服务中的主导地位,其生态整合能力将加速 AI 训练从数据依赖向算法驱动的范式转变。

开源社区

开源社区通过技术民主化进程深刻重塑合成数据生态,其核心价值体现在三大维度:

降低技术门槛:如数据合成工具包 SDV 提供低代码可视化界面,使非专业开发者能快速生成结构化合成数据。

推动标准化建设:SDMetrics 等开源评估工具建立数据相似性、隐私保护与可用性的量化指标体系。

促进跨领域协作:典型案例如医疗 AI 社区联合开发的合成影像数据集,在规避隐私风险前提下实现临床数据共享。

典型开源项目矩阵:

文本合成:Faker 库支持 45 种语言的伪数据生成,GitHub 星标数超 15 万。

自动驾驶:Synthia 数据集包含 12 万帧标注图像,覆盖 11 种天气与光照条件。

鉴别技术:DeepFake Detection Challenge 吸引 2.5 万研究者参与,推动合成内容检测算法迭代。

开源模式面临双重挑战:质量控制方面,社区贡献的数据集存在标注精度差异;商业化层面,企业需平衡开源生态维护与知识产权保护。2020 - 2026 年合成数据开源项目数量呈现指数级增长,反映出社区协作在技术突破中的关键作用。

投资趋势

合成数据领域的资本流动呈现显著的阶段性演变特征。

早期阶段 (2020 - 2022年):投资主要集中于通用技术研发。

成长期 (2023 - 2025年):投资转向垂直场景落地,医疗与自动驾驶成为重点赛道。这种转变反映了技术成熟度提升后,市场对实际应用价值的追求。

从地域分布看,全球投资呈现明显分化。

美国:以58%的占比主导市场。

欧洲:侧重隐私合规技术研发。

中国:聚焦工业场景应用,形成各具特色的发展路径。

2025年合成数据领域投资行业分布显示,垂直领域已占据主导地位。医疗和自动驾驶领域的投资占比显著提升,通用技术占比相对下降,体现了资本向应用端的倾斜。

展望2026年,投资趋势将呈现三大特征:

平台型企业整合加速:技术优势企业将通过合并扩大市场份额。

跨行业并购增加:垂直领域龙头加速产业链布局。

战略投资占比提升:科技巨头CVC将加大生态投资力度。

资本的持续涌入和布局调整,将进一步推动合成数据技术的创新与应用,为AI训练数据瓶颈的突破提供有力支撑。

挑战与风险

数据偏见与质量陷阱

合成数据在解决数据稀缺问题的同时,其偏见与质量问题可能成为AI系统部署的潜在风险。风险根源可从三个维度分析:

技术层面:生成模型通过学习训练数据中的历史偏见(如性别、种族关联特征),可能复制甚至放大原有数据集中的歧视模式。

流程层面:缺乏标准化的偏见检测与量化评估机制,导致偏见难以被系统识别。

伦理层面:人类标注者的主观偏好(如标注标准不一致)可能被编码到合成数据中,形成隐性偏见传递链。

为系统性治理合成数据偏见,需构建“偏见缓解框架”:

输入多样化:通过多样化训练数据输入(如跨领域、跨人群样本融合)降低单一数据源的偏见影响。

指标量化:建立偏见量化指标体系,如采用 demographic parity(人口学平等)确保不同群体在关键决策指标上的分布均衡。

人机协同审核:实施人机协同审核机制,结合自动化工具与领域专家判断,形成偏见治理闭环。

实践中,IBM 的 AI Fairness 360 工具已在合成数据治理中展现应用价值,其提供的 70 余种偏见检测指标与缓解算法,可有效识别并修正合成数据中的群体歧视问题。通过技术干预与流程优化,合成数据的偏见治理已具备可行性基础。

关键发现:技术层面的模型学习机制、流程层面的标准缺失、伦理层面的主观偏好,共同构成合成数据偏见的三大根源。通过“输入多样化-指标量化-人机审核”的三阶框架,可实现合成数据偏见的有效治理。

版权与法律问题

合成数据技术的快速发展正遭遇法律体系的滞后性挑战,核心矛盾体现为三大法律困境:

版权归属不明确:合成数据是否构成对原始数据的衍生作品,现有法律框架尚未形成统一认定标准,导致企业在数据使用中面临潜在侵权风险。

责任认定模糊:当AI模型因合成数据质量缺陷引发决策错误时,数据生成方、模型训练方与应用方之间的责任划分缺乏明确依据。

跨境合规复杂性:不同地区对数据主权的差异化要求(如欧盟GDPR的数据本地化原则与美国的数据自由流动主张),使得跨国企业的合成数据应用面临多重合规障碍。

法律框架三大建议:

明确独立权利属性:立法确认合成数据作为独立数据类型的法律地位,与原始数据版权分离。

建立来源追溯机制:要求合成数据生成过程保留原始数据来源记录,确保可审计性。

推动国际统一标准:支持世界知识产权组织(WIPO)制定合成数据版权指南,协调跨境合规规则。

全球合成数据法规呈现显著区域差异:

欧盟:倾向于严格的数据权利保护,要求合成数据必须完全脱敏且不可追溯至个人。

美国:采取行业自律为主的监管模式,鼓励技术创新。

中国

:强调数据安全与发展平衡,要求关键领域合成数据需通过安全审查。

这种区域差异加剧了企业的合规成本,凸显建立国际统一标准的紧迫性。

安全性与对抗攻击

合成数据在缓解 AI 训练数据瓶颈的同时,也面临着严峻的安全挑战。构建“攻击-防御”对抗模型是保障合成数据安全的核心思路。

攻击者主要路径:

数据投毒:向训练数据注入后门,例如在合成图像中嵌入隐藏特征,当模型遇到特定触发条件时会产生错误输出。

模型窃取:通过合成数据反向工程提取模型参数,导致模型知识产权泄露和性能降级。

防御体系(三个环节):

生成环节:可嵌入基于区块链的不可见水印,实现数据溯源和篡改检测。

训练环节:引入隔离森林算法等异常检测机制,识别并剔除恶意数据。

供应链环节:建立合成数据供应链安全审计机制,对数据生成工具、处理流程和分发渠道进行全链路监控。

微软的 Synthetic Data Shield 解决方案为安全防护提供了实践参考,该方案整合了水印嵌入、异常检测和供应链审计功能,形成端到端的安全防护体系。通过多维度防御策略的协同作用,能够有效降低合成数据被恶意利用的风险,为 AI 模型训练提供安全可靠的数据基础。

合成数据安全防护体系核心要点:

生成层:区块链水印嵌入实现数据溯源。

训练层:隔离森林算法检测异常数据。

供应链层:全链路安全审计与监控。

评估标准的缺失

合成数据行业面临的核心挑战之一是评估标准的系统性缺失,这直接导致三大行业痛点:

采购决策困难:市场上超过 300 种合成数据工具的性能参数互不兼容,采购决策往往依赖供应商自证或主观测试。

模型性能不稳定:同一算法在不同合成数据集上的训练准确率差异可达 20%,严重制约了 AI 系统的工业化部署。

行业信任度不足:据 Gartner 2025 年调查,仅 23% 的企业愿意将合成数据用于核心业务场景,远低于真实数据 78% 的信任度。

为破解这一困局,行业亟需建立多维度评估体系。该框架应包含三大核心维度:

技术维度:考核数据保真度(如分布相似度、特征相关性)和多样性(覆盖边缘案例比例)。

业务维度:评估任务适配性(特定场景下的模型性能损耗率)和成本效益(对比真实数据采集成本)。

伦理维度:验证偏见抑制效果(敏感属性分布偏差率)和隐私保护强度(如差分隐私参数)。

国际标准化组织已发布 ISO/IEC 22690 标准,其中明确规定合成数据与原始数据的分布相似度需达到 95% 以上,为技术评估提供了基准。

标准化评估的实施可借鉴美国国家标准与技术研究院(NIST)开发的合成数据评估工具包(SDTK)。该工具包通过 12 项量化指标自动生成评估报告,涵盖从统计特性到下游任务性能的全链条分析。某金融科技企业应用 SDTK 后,合成数据选型周期从平均 45 天缩短至 12 天,模型部署故障率降低 67%,验证了标准化评估的实用价值。

多维度评估体系核心指标:

技术维度:分布相似度(≥95%)、特征相关性(≥0.9)、边缘案例覆盖率(≥80%)

业务维度:任务准确率损耗(≤5%)、数据生成成本(较真实数据降低≥30%)

伦理维度:偏见放大系数(≤1.1)、隐私泄露风险(趋近于 0)

未来展望

技术融合趋势

合成数据技术正通过多维度技术协同突破发展边界,呈现三大融合趋势:

生成式 AI 与合成数据的双向赋能:

大型语言模型(LLM)凭借逻辑推理能力生成结构化合成数据,如金融交易记录、医疗电子病历等复杂场景数据。

合成数据通过构建特定领域知识增强数据集,反哺 LLM 训练,提升模型在专业场景的理解精度。

区块链技术确保可信流转:通过将合成数据集 NFT 化,实现数据所有权的确权与溯源,解决传统数据交易中的版权争议问题。

边缘计算推动实时合成落地:典型应用如自动驾驶汽车在本地端实时生成极端天气、复杂路况等边缘场景数据,降低云端传输延迟与隐私风险。

自主进化合成数据成为下一代技术突破方向:模型通过内置反馈机制,持续接收下游任务性能数据(如模型识别准确率、决策误差率),动态优化合成策略,实现数据质量的自我迭代。这种闭环进化能力使合成数据系统能自适应不同应用场景的需求变化。

技术融合路线图呈现阶梯式发展路径:基础层实现生成式 AI 与合成数据工具链整合;中间层通过区块链构建可信数据流通网络;应用层依托边缘计算实现实时合成部署;最终迈向自主进化阶段,形成具备自我优化能力的智能数据生成系统。

行业标准化

合成数据行业的规范化发展需要构建科学的标准层级模型,该模型自下而上分为四个核心层次:

基础层:聚焦术语定义与数据格式统一,为行业交流奠定语言基础。

技术层:规范生成流程与质量指标,确保合成数据的可靠性与一致性。

应用层:针对医疗、金融等垂直领域制定特定要求,满足场景化需求。

伦理层:围绕偏见治理与透明度建立准则,保障技术的负责任应用。

推动标准化进程的核心驱动力来自三方面:企业通过统一标准降低合规成本,跨机构数据共享需求促进协同创新,公众信任建立则为技术规模化应用提供社会基础。

在此背景下,IEEE P3184 标准提出的“合成数据护照”概念具有里程碑意义,该机制通过记录数据来源、生成方法、质量指标等元数据,实现合成数据全生命周期的可追溯与可验证,有效推动行业从技术探索向规范化应用转型。

标准层级模型金字塔结构:

伦理层:偏见治理、透明度

应用层:行业特定要求

技术层:生成流程、质量指标

基础层:术语定义、数据格式

这一多层次标准化体系不仅解决了合成数据的技术可信度问题,更为跨领域协作与监管合规提供了框架支持,成为打破 AI 训练数据瓶颈的关键基础设施。

商业模式创新

合成数据行业的商业模式正经历双重转型:从传统的“工具销售”模式向“数据服务”模式升级,同时从通用型解决方案向垂直行业定制化服务聚焦。

这一演进推动了三类新兴商业模式的崛起:

合成数据交易所:如 Synthetic Data Exchange,通过连接数据生成者与使用者,构建高效的供需匹配机制。

基于区块链的合成数据 NFT:将数据资产化,实现可追溯的所有权管理与价值流转。

“数据保险”服务:针对合成数据的质量风险提供保障,增强市场信任度。

平台化商业模式展现显著优势,以 Snowflake 的合成数据市场为例,其通过集成数据生成工具、质量验证与交易结算功能,降低了行业准入门槛并提升了数据流通效率。

据预测,2026 年合成数据市场商业模式占比分布为:

垂直行业解决方案:38%

数据服务模式:32%

工具销售:20%

新兴模式(交易所、NFT、保险等):10%

商业模式演进核心特征:

价值重心转移:从软件许可收入转向数据订阅与增值服务。

行业深度渗透:医疗、金融等监管敏感领域成为垂直解决方案主战场。

信任机制创新:区块链与保险服务共同构建数据质量保障体系。

关键预测

本章节从技术、市场与社会三个维度,对2026-2030年合成数据领域的发展趋势进行前瞻性分析,并配套具体指标与风险应对策略。

技术维度:成本持续优化与能力突破

成本预测:预计到2027年,多模态合成数据生成成本将降至真实数据采集标注成本的1/10,这一降幅主要得益于生成式AI模型效率提升与分布式训练技术的成熟。

能力预测:技术突破将推动合成数据在复杂场景的应用,例如医疗领域,2029年合成医疗数据有望覆盖95%的罕见病类型,解决真实病例稀缺问题。

市场维度:垂直行业解决方案成为主流

市场结构:将发生显著变化,2028年垂直行业定制化解决方案占比预计超过60%,反映出合成数据从通用工具向场景化应用的转型。

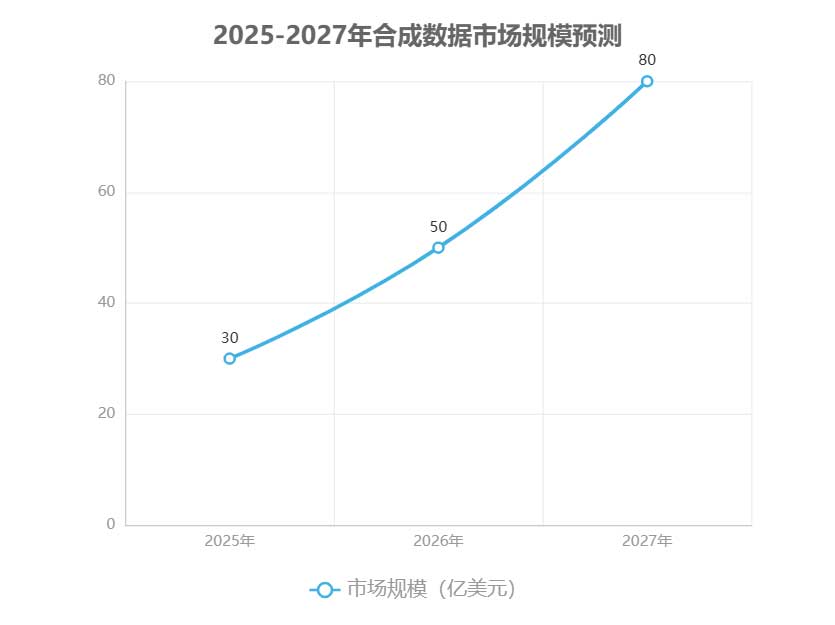

市场规模:呈现加速增长态势,2025年预计达到30亿美元,2026年增至50亿美元,2027年进一步突破80亿美元。

社会影响:推动AI民主化进程

积极影响:合成数据将打破数据壁垒,使中小企业能够以可负担成本获取高质量训练数据,加速AI技术在各行业的普及。

风险应对:需警惕数据偏误与隐私滥用风险,建议建立行业标准与监管框架,确保技术发展的可控性与公平性。

核心预测指标:

技术成本:2027年多模态合成数据成本为真实数据的10%

市场结构:2028年垂直行业解决方案占比超60%

社会渗透:2029年合成医疗数据覆盖95%罕见病类型

市场规模预测显示,合成数据产业将在未来五年保持年均40%以上的复合增长率,成为AI基础设施的关键组成部分。这一增长不仅源于技术进步,更来自各行业对数据安全与合规需求的提升。

行动建议

企业层面:构建合成数据能力体系

企业应建立三级推进机制以系统性落地合成数据战略。

组建合成数据实验室:整合数据工程、机器学习与垂直领域专家,配置至少 5 人以上专职团队,重点突破行业特定数据生成算法。

开展试点项目:建议优先选择金融风控、医疗影像等高价值场景开展试点,分三阶段实施:

首月:完成数据需求分析与工具选型。

2个月内:搭建最小化验证环境。

3个月内:完成 POC 验证并评估模型效果提升幅度。

据实践案例显示,该路径可使企业在 6 个月内实现数据获取成本降低 30%,AI 模型迭代周期缩短 40%。

参与行业标准建设:主动参与 IEEE P3184 等合成数据可信度评估标准制定,联合 3 - 5 家行业头部企业共建数据安全合规联盟,推动形成场景化应用指南。

企业可依据“合成数据成熟度评估矩阵”定期自检,该矩阵从技术能力(如算法成熟度、隐私保护深度)与应用效果(如业务场景覆盖率、模型性能提升幅度)两个维度,分为初始级、可重复级、已定义级、优化级四个阶段,帮助企业明确能力短板与提升路径。

政府层面:完善政策支持与生态建设

政府需构建“资金 + 共享 + 法规”三位一体的政策支撑体系。

设立专项资金:建议设立每年不低于 2 亿元的合成数据产业发展基金,采用“前补助 + 后奖励”模式。

对技术研发项目给予最高 30% 的研发费用补贴。

对产业化项目按市场营收给予阶梯式奖励。

实施要点:专项基金应向中小企业倾斜,设置不低于 40% 的配额比例。

建设跨部门数据共享机制:由工信部牵头建立国家级合成数据资源池,首批接入金融、医疗等 8 个重点领域的脱敏数据,采用联邦学习技术实现“数据可用不可见”,突破“数据孤岛”。

完善法律法规:需聚焦三个方向:

明确合成数据的法律地位与权属界定。

制定《合成数据安全管理办法》,建立生成过程的审计追溯机制。

在 GDPR 框架下细化合成数据的跨境流动规则。

研究机构层面:突破核心技术与人才瓶颈

研究机构需重点攻关两大技术方向,并创新人才培养模式。

核心技术攻关:

因果合成技术:构建基于物理规则与因果推理的双驱动生成模型,突破传统生成对抗网络(GANs)在复杂系统模拟中的局限性,实现动态场景下的高保真数据生成。

偏见治理技术:建立多维度偏见检测指标体系,开发自动化偏见修正算法,确保合成数据的公平性与代表性。

跨学科人才培养:采用“课程体系 + 项目实践”双轨模式。

课程体系:在计算机科学专业开设《合成数据生成原理》《数据隐私保护技术》等核心课程。

项目实践:联合企业设立实习基地,每年培养不少于 200 名复合型人才。

实施要点:研究机构需建立技术开源平台,加速成果转化应用。

通过政企研协同推进,可形成技术突破 - 场景验证 - 标准制定的良性循环,推动合成数据产业在 2026 - 2028 年进入规模化应用阶段,有效缓解 AI 训练数据供给不足的行业痛点。

企业实施要点:试点阶段需控制场景数量,聚焦 1 - 2 个垂直领域深耕。

附录:术语表与参考文献

术语表

技术基础

合成数据(Synthetic Data):通过算法生成的、不直接来源于真实世界但保留原始数据统计特性和分布特征的人工数据,可用于模型训练、测试或隐私保护场景。

生成式 AI(Generative AI):一类能够通过学习数据分布规律生成新内容的人工智能技术,核心模型包括生成对抗网络(GANs)、变分自编码器(VAEs)等,是合成数据生成的关键技术支撑。

数据分布(Data Distribution):描述数据集中各特征取值及其概率的数学模型,合成数据需在关键分布特征(如均值、方差、相关性)上与真实数据保持一致。

隐私保护技术(Privacy-Preserving Technologies):在数据处理过程中保护个人隐私信息的技术体系,包括差分隐私、联邦学习、安全多方计算等,常与合成数据结合使用以降低数据泄露风险。

生成方法

生成对抗网络(GANs):由生成器和判别器组成的深度学习模型,通过对抗训练机制生成高度逼真的数据,适用于图像、语音等复杂模态合成数据的生成。

变分自编码器(VAEs):基于概率图模型的生成模型,通过学习数据的潜在概率分布实现数据生成,具有较好的稳定性和可解释性,常用于结构化数据合成。

规则式生成(Rule-Based Generation):基于预设逻辑规则和业务知识生成数据的方法,适用于简单场景或需要严格控制数据特征的领域,如金融交易流水模拟。

混合生成策略(Hybrid Generation Strategy):结合深度学习模型与传统统计方法的合成数据生成方案,例如使用 GANs 生成复杂特征、规则式方法补充业务约束,以平衡生成效果与可控性。

质量评估

统计相似度(Statistical Similarity):衡量合成数据与真实数据在统计特征上的一致程度,常用指标包括均值误差、分布距离(如 KL 散度)、特征相关性系数等。

生成多样性(Generative Diversity):评估合成数据覆盖原始数据分布范围的能力,避免模式崩溃(Mode Collapse)导致的样本单一化问题,可通过覆盖率、熵值等指标量化。

下游任务性能(Downstream Task Performance):将合成数据用于目标任务(如分类、检测)时的模型表现,是衡量合成数据实用性的核心指标,通常与真实数据训练的基准模型对比评估。

隐私风险评估(Privacy Risk Assessment):对合成数据泄露原始敏感信息风险的量化分析,关键指标包括成员推理攻击成功率、属性推断准确率、重构风险等。

应用场景

医疗影像合成(Medical Image Synthesis):生成标注完整的医学影像数据(如 CT、MRI 图像),用于扩充训练样本库或辅助罕见病例研究,解决医疗数据稀缺与隐私保护难题。

自动驾驶仿真(Autonomous Driving Simulation):构建虚拟交通场景数据(如道路环境、行人行为、天气条件),支持自动驾驶系统在安全可控的虚拟环境中进行大规模测试与算法优化。

金融风控建模(Financial Risk Modeling):生成包含欺诈交易、信用违约等边缘案例的合成金融数据,提升风控模型对极端风险的识别能力,同时避免真实客户信息泄露。

边缘设备训练(Edge Device Training):针对计算资源受限的边缘设备(如物联网终端),生成轻量化合成数据以降低模型训练的数据传输成本和隐私风险。

参考文献

学术研究

Goodfellow, I., et al. (2023). "Generative Adversarial Networks: Theory and Applications in Synthetic Data Generation". IEEE Transactions on Pattern Analysis and Machine Intelligence.

Kingma, D. P., & Welling, M. (2024). "Variational Autoencoders: A Review of Methods and Applications in Structured Data Synthesis". Journal of Machine Learning Research.

Dwork, C., & Roth, A. (2025). "The Algorithmic Foundations of Differential Privacy in Synthetic Data". Foundations and Trends in Theoretical Computer Science.

行业报告

Gartner. (2024). Synthetic Data: The Key to Unlocking AI Scalability. Gartner Research Report.

McKinsey & Company. (2025). The Economic Impact of Synthetic Data: Industry Adoption Trends and Market Forecasts 2025-2030.

World Economic Forum. (2023). Synthetic Data for Trustworthy AI: A Global Framework for Responsible Development.

标准文件

ISO/IEC 27701:2024. Information Security, Cybersecurity and Privacy Protection — Extension to ISO/IEC 27001 for Privacy Information Management Systems — Guidelines for Synthetic Data Governance.

NIST SP 800-222 Rev. 1 (2025). Guidelines for the Use of Synthetic Data in Federal Agencies.

EU AI Act Implementing Regulation (2024). Technical Standards for Synthetic Data in High-Risk AI Systems.