算力·能源·碳:2026算力基础设施与“能源墙”危机洞察报告

2026-01-22 14:21:00

#算力#能源#碳

算力·能源·碳

当AI的算力需求以指数级增长,能源供给却陷入瓶颈之时物理世界正在对数字世界发起反噬

160%

2030年全球数据中心电力需求增长

核能复兴

科技巨头押注下一代能源

47 GW

美国2025-2028年电力缺口

报告发布时间:2026年1月

执行摘要

核心发现:AI越强大,耗电越狠——这不再是一句戏言,而是2026年全球科技产业面临的最严峻挑战之一。

随着生成式人工智能(Generative AI)在全球范围内的爆发式应用,从ChatGPT到Midjourney,从自动驾驶到工业智能制造,AI模型的参数规模与推理频次正以前所未有的速度呈指数级增长。然而,支撑这一数字革命的物理基础设施——数据中心,却正在遭遇一场深刻的能源危机。这场危机的本质,在于算力需求的无限扩张与能源供给的有限承载能力之间,出现了一道难以逾越的"能源墙"(Energy Wall)。

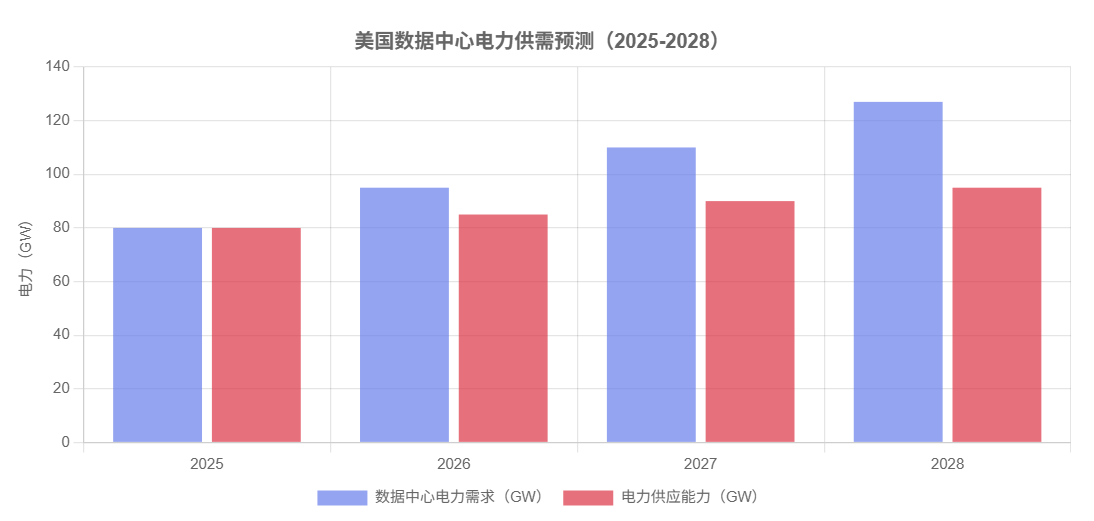

根据高盛研究部的最新预测,到2030年,全球数据中心的电力需求将比当前水平激增160%。国际能源署(IEA)则更为具体地指出,全球数据中心的用电量将在2030年达到约945太瓦时(TWh),这一数字相当于整个日本一年的用电总量。更令人震惊的是,摩根士丹利的最新报告将2025至2028年间美国数据中心的累计电力缺口从44吉瓦(GW)上调至47吉瓦——这相当于9个迈阿密市或15个费城市的全部用电量。电力供给不足,已经成为制约AI算力扩张的核心瓶颈。

这场能源危机不仅仅是技术问题,更演变成了一场涉及经济、社会、环境与地缘政治的多维挑战。在美国北弗吉尼亚等数据中心高度集中的地区,居民电价在过去数年内暴涨超过200%,"数据中心与民争电"的矛盾日益激化。与此同时,为了寻求稳定、零碳的基荷电源,全球科技巨头正在掀起一场"核能复兴"运动。Meta、微软、谷歌和亚马逊等公司纷纷与核能企业签署长期购电协议,押注小型模块化反应堆(SMR)这一下一代核能技术,试图在能源转型中抢占先机。

本报告将深入剖析2026年AI算力基础设施所面临的"能源墙"危机,系统分析其形成机制、多维影响、技术瓶颈与应对策略,并对全球竞争格局与未来趋势进行前瞻性展望,为政策制定者、投资者与行业从业者提供关键洞察。

一、AI算力需求的爆炸性增长:从训练到推理的范式转变

1.1 模型规模的指数级膨胀

过去五年间,AI大模型的参数规模经历了令人瞠目的增长。从2018年BERT的3.4亿参数,到2020年GPT-3的1750亿参数,再到2023年GPT-4的传闻万亿级参数,模型规模的增长速度远超摩尔定律的预测。这种指数级膨胀不仅体现在参数数量上,更反映在训练与推理所需的计算资源上。根据斯坦福AI研究所的数据,GPT-3的单次训练就消耗了1287兆瓦时(MWh)的电力,相当于一个中型城市一天的用电量。

更为关键的是,AI算力需求的结构正在发生深刻转变。如果说过去五年的重点在于"训练"(Training)——即通过大规模计算训练出性能优异的基础模型,那么2026年之后,"推理"(Inference)将成为算力消耗的主导力量。随着ChatGPT、Claude、Gemini等大模型进入大规模商业化阶段,数以亿计的用户每天产生的推理请求,使得推理算力的总消耗量已经开始超越训练算力。国际能源署指出,仅英伟达(NVIDIA)供应的GPU集群,到2030年预计将消耗150至200吉瓦(GW)的电力,这相当于1.5至2个法国全年的用电总量。

1.2 数据中心规模的爆炸性扩张

为了满足不断膨胀的算力需求,全球科技巨头正在以前所未有的速度扩建数据中心。一个超大型AI数据中心的耗电量,已经可以抵得上一座拥有数十万人口城市的全部用电。根据统计,美国本土目前已有超过4000个大型数据中心,而未来四年内,这一数字可能翻三倍,达到12000个以上。

数据中心密度的地理集中

在美国,数据中心的分布呈现出高度的地理集中特征。北弗吉尼亚、俄勒冈、爱荷华等地因靠近电力枢纽或拥有相对廉价的电力资源,成为数据中心建设的热点区域。然而,这种集中也带来了严重的问题:在北弗吉尼亚等地区,居民电价在过去数年内暴涨超过200%,远高于通胀水平,引发了激烈的社会矛盾。

1.3 从"暴力扩展"到"推理奇点"

AI产业正在经历一场从"暴力扩展"(Scaling Brutally)到"推理奇点"(Inference Singularity)的范式转变。在过去,AI公司主要通过不断增加模型参数、训练数据和计算资源来提升模型性能,这种"大力出奇迹"的策略虽然有效,但也带来了难以为继的能源消耗。2026年之后,随着推理需求的全面接管,AI产业必须在保持性能的同时,大幅提升能效比。这不仅需要硬件层面的创新——如更高效的AI芯片和液冷技术,也需要软件层面的优化——如模型压缩、量化与稀疏化。

关键数据点

2030年全球数据中心电力需求:945 TWh(IEA预测)

电力需求增长幅度:160%(高盛研究部)

NVIDIA GPU集群预计耗电:150-200 GW(相当于1.5-2个法国的年用电量)

GPT-3单次训练耗电:1287 MWh

二、"能源墙"危机的多维表现:从技术到社会的全面挑战

2.1 电力供需失衡:美国案例研究

美国作为全球AI产业的中心,正在经历最为严重的电力供需失衡危机。摩根士丹利的最新报告显示,2025至2028年间,美国数据中心的累计电力缺口已从44吉瓦上调至47吉瓦,这相当于9个迈阿密市或15个费城市的全部用电量。电力供给不足,已经成为制约AI算力扩张的核心瓶颈。

这种供需失衡的根源,在于美国电力基础设施的严重老化。高盛研报指出,美国电网的平均使用年限已达35至40年,面对AI数据中心爆发式的能耗需求,这些老旧的基础设施显得极为脆弱。更为严峻的是,美国本土的电力设备产能仅能满足约40%的市场需求,而新建电力项目的并网等待时间已延长至近5年。这意味着,即便现在开始大规模投资电力基础设施建设,也难以在短期内缓解供需矛盾。

2.2 "与民争电":社会矛盾的激化

数据中心对电力的巨大需求,正在引发严重的社会矛盾。在美国北弗吉尼亚等数据中心高度集中的地区,居民电价在过去数年内暴涨超过200%,远高于通胀水平。这种涨幅主要源于两个因素:一是数据中心直接抢占了原本用于民用的电力资源;二是为了满足数据中心的电力需求,电力公司不得不投资大量资金进行电网升级,而这些成本最终通过电费转嫁给了普通居民。

PJM区域的电力容量市场危机

在美国最大的区域电力市场PJM(宾夕法尼亚-新泽西-马里兰互联系统),电力容量市场的成本正在急剧上升。2026至2027年度的拍卖总容量成本约为164亿美元,其中与数据中心相关的成本已占到总成本的近50%。这些上涨的成本,最终将通过更高的电费由普通消费者承担。

随着民众情绪的日渐不满,电力资源挤兑已迅速外溢为社会性议题。纽约州等地的监管机构已开始要求大型数据中心承担更多责任,如支付更高的接入费用和长期容量义务,以避免成本过度转嫁给普通用户。

2.3 电网稳定性与可靠性挑战

AI数据中心对电力的需求不仅体现在总量上,更体现在对稳定性与可靠性的极高要求上。与传统的民用或工业用电不同,AI数据中心需要24小时不间断的电力供应,任何瞬时的电力波动或中断,都可能导致大规模的计算任务失败,造成巨大的经济损失。根据PJM的预测,未来十年,该区域的电力需求将以年均4.8%的速度增长,而新增负载几乎全部来自数据中心和AI应用。然而,发电与输电建设的速度明显跟不上这一节奏,这对电网的稳定性与可靠性构成了严峻考验。

电网挑战的三大维度

容量不足:现有电网的输电容量无法满足数据中心的峰值需求

稳定性欠佳:老化的电网设备容易出现故障,影响供电稳定性

响应速度慢:新建电力项目的并网周期长达5年,无法快速响应需求增长

2.4 碳排放与气候目标的矛盾

AI算力需求的爆炸性增长,与全球应对气候变化的努力形成了尖锐矛盾。根据估算,到2030年,AI行业的碳排放量将占全球碳排放的3.5%。更令人担忧的是,为了满足数据中心的电力需求,一些地区不得不推迟燃煤电厂的退役计划,甚至重启已经关闭的化石燃料发电设施,这无疑与各国的碳中和承诺背道而驰。

与此同时,科技巨头们虽然纷纷承诺实现碳中和或碳负排放,但实际行动却远远滞后于承诺。以微软为例,该公司在2020年承诺到2030年实现碳负排放,但随着其AI业务的快速扩张,碳排放量不降反升。这种"言行不一"的现象,正在引发越来越多的质疑与批评。

三、核能复兴:科技巨头的能源新赛道

3.1 为何是核能?稳定基荷电源的唯一选择

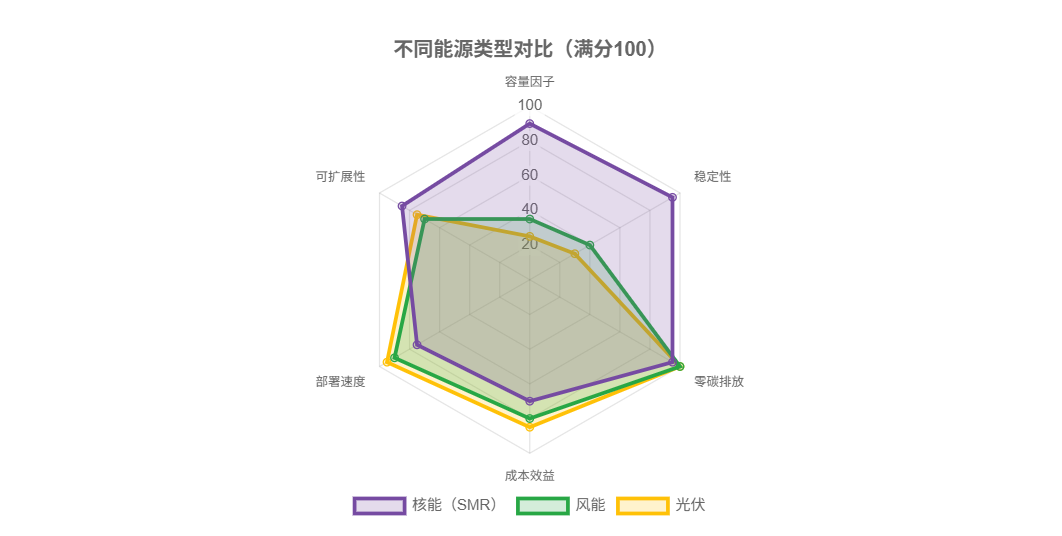

在寻求满足AI算力需求的清洁能源解决方案时,科技巨头们不约而同地将目光投向了核能。这背后有着深刻的技术与经济逻辑。传统的风电、光伏等可再生能源虽然清洁,但其波动性难以支撑AI算力中心对高度稳定电力的需求。太阳能只能在白天发电,风能则取决于风况,而AI数据中心需要的是24小时不间断、稳定可预测的电力供应。

相比之下,核能作为一种稳定、可预测且可调度的基荷电源(Baseload Power),几乎是满足AI算力中心电力需求的完美选择。核电站可以提供持续、稳定的电力输出,容量因子(Capacity Factor)高达90%以上,远超风电的35%和光伏的25%。更为重要的是,核能在发电过程中几乎不产生碳排放,符合科技巨头们的碳中和承诺。

3.2 小型模块化反应堆(SMR):下一代核能技术

科技巨头们押注的并非传统的大型核电站,而是新一代的小型模块化反应堆(Small Modular Reactor, SMR)。SMR的设计理念是将核反应堆模块化、小型化,使其更加灵活、安全且易于部署。典型的SMR单堆功率通常不超过300兆瓦电力(MWe),远小于传统核电站的1000 MWe以上,但可以通过模块化部署实现灵活扩展。

SMR的核心优势

技术优势

模块化部署:12-24个月即可完成部署,远快于传统核电站的5-10年

固有安全性:采用被动安全系统,大幅降低事故风险

灵活选址:可部署在靠近数据中心的位置,减少输电损耗

经济优势

降低资本风险:初始投资规模小,分散建设风险

工厂化制造:可在工厂批量生产,降低成本

快速响应:能够快速响应算力中心的电力需求增长

3.3 科技巨头的核能布局

2024至2026年间,科技巨头们掀起了一波密集的核能投资与合作浪潮,标志着"核能复兴"正式进入实质性阶段。以下是主要科技公司的核能战略布局:

Meta(Facebook)

2026年1月,Meta宣布与TerraPower、Oklo和Vistra三家核能企业达成战略合作,计划到2035年支持高达6.6吉瓦(GW)的清洁能源。这是迄今为止科技公司在核能领域最大规模的单笔投资。

合作伙伴:TerraPower(比尔·盖茨投资)、Oklo(先进快堆技术)、Vistra(传统电力公司)

微软(Microsoft)

2024年9月,微软与Constellation Energy签署了一项为期20年的购电协议,后者将重启美国宾夕法尼亚州三哩岛(Three Mile Island)核电站1号机组,为微软的数据中心提供835兆瓦(MW)的无碳能源。这是自1979年三哩岛核事故以来,美国首次重启关闭的核电机组。

重启意义:标志着美国核电政策的重大转向,打破了长达40余年的核电"禁忌"

谷歌(Google)

2024年10月,谷歌与Kairos Power签署了长期合作协议,目标是通过多次部署SMR,释放500兆瓦(MW)的核电清洁能源。Kairos Power专注于熔盐冷却反应堆技术,被视为下一代核能的代表性企业。

技术特点:熔盐冷却反应堆具有更高的安全性和热效率

亚马逊(Amazon)

亚马逊与X-energy展开合作,计划到2039年在美国部署超过5吉瓦(GW)的核电装机容量。这一规模相当于5座大型传统核电站的总装机量。

战略目标:为AWS云服务提供稳定、清洁的电力支撑

科技巨头核能投资总览

| 公司 | 目标装机容量 | 预计完成时间 | 技术路线 |

|---|---|---|---|

| Meta | 6.6 GW | 2035年 | SMR + 先进快堆 |

| 亚马逊 | 5 GW | 2039年 | SMR(X-energy) |

| 微软 | 835 MW | 已启动 | 传统核电重启 |

| 谷歌 | 500 MW | 逐步部署 | 熔盐冷却反应堆 |

数据来源:新浪财经

3.4 核能复兴的地缘政治意涵

科技巨头们的核能布局,不仅是一场技术与商业的竞赛,更具有深刻的地缘政治意涵。在当前中美科技竞争的大背景下,能源自主与供应链安全已成为国家战略的重要组成部分。美国通过推动SMR技术的商业化,试图在下一代核能技术领域建立全球领先地位,从而在能源转型中掌握主导权。

与此同时,中国也在积极布局先进核能技术。中国已经建成并投运了多个SMR示范项目,并在第四代核电技术(如高温气冷堆、快中子增殖反应堆)方面取得了重要突破。未来,中国可能通过"AI + 算力中心 + 数据中心 + 先进核能 + 新能源"的综合场景示范,探索一条不同于美国的能源转型路径。

四、碳排放与可持续性挑战:绿色承诺的现实考验

4.1 AI的碳足迹:被低估的环境代价

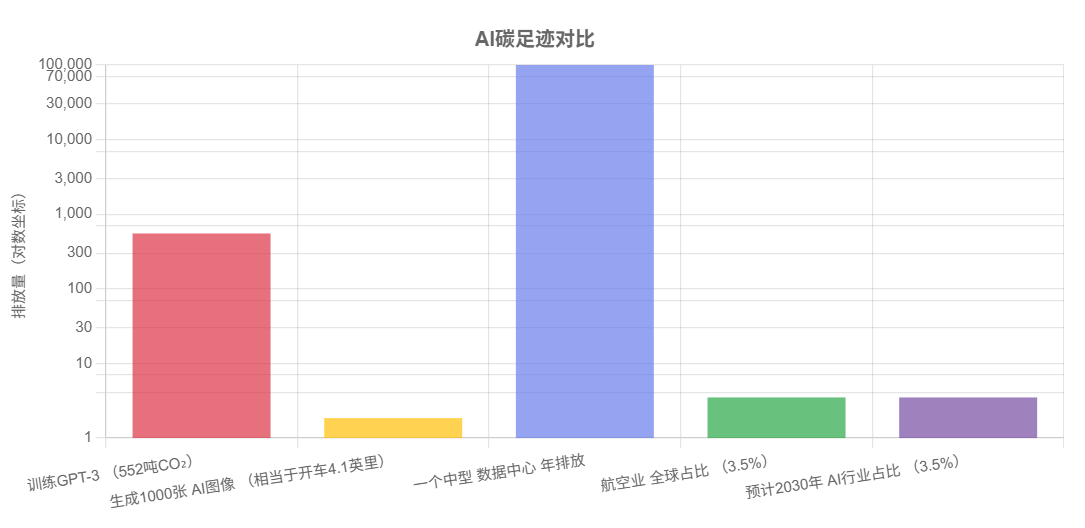

长期以来,AI被视为一种"清洁"技术,人们更关注其在提升效率、减少资源浪费方面的积极作用。然而,随着AI应用的普及,其巨大的碳足迹正逐渐暴露出来。根据斯坦福AI研究所的估算,训练一个像GPT-3这样的大型语言模型,会产生约552吨的二氧化碳排放,相当于一个普通美国人125年的碳排放量。

更令人担忧的是,这还只是训练阶段的碳排放。随着AI进入大规模推理应用阶段,其总碳排放量将远超训练阶段。研究显示,生成1000张AI图像所产生的碳排放,相当于开一辆汽油车行驶约4.1英里。如果按照目前的增长趋势,到2030年,AI行业的碳排放量将占全球总排放的3.5%,这一比例已经接近航空业的全球碳排放占比。

4.2 科技巨头的碳中和承诺:言行不一的尴尬

面对日益严峻的气候危机,几乎所有的科技巨头都承诺在未来实现碳中和或碳负排放。然而,随着AI业务的快速扩张,这些承诺正面临严峻考验。以微软为例,该公司在2020年宣布到2030年实现碳负排放的雄心勃勃的目标,但根据其最新发布的可持续发展报告,2024年的碳排放量较2020年不降反升,增长了约30%。微软将这一增长归咎于其数据中心的快速扩张和AI业务的增长。

类似的情况也出现在谷歌、亚马逊等公司。虽然这些公司都在积极投资可再生能源,但在实际操作中,为了满足数据中心的电力需求,它们不得不依赖传统的化石燃料发电。一些研究指出,科技巨头们通过购买"绿色电力证书"(Renewable Energy Certificates, RECs)来"抵消"其碳排放的做法,实际上只是一种会计技巧,并未真正减少实际的碳排放。

"漂绿"(Greenwashing)的质疑

越来越多的环保组织和研究机构开始质疑科技巨头们的碳中和承诺,认为其中存在大量的"漂绿"行为。所谓"漂绿",是指企业通过误导性的营销手段,使公众相信其产品或政策比实际情况更加环保。例如,一些公司宣称其数据中心使用100%可再生能源,但实际上只是购买了等量的绿色电力证书,而数据中心本身仍在使用电网中的混合电力,其中包含大量的化石燃料发电。

4.3 数据中心的水资源消耗:被忽视的环境影响

除了电力消耗和碳排放,数据中心对水资源的消耗也是一个日益严重的环境问题。为了冷却大量发热的服务器,数据中心需要消耗大量的水。根据估算,一个中型数据中心每天的用水量可达数百万加仑,相当于一个小城镇的用水量。在水资源短缺的地区,数据中心的用水需求正在与农业、民用争夺有限的水资源。

以谷歌为例,该公司在美国亚利桑那州梅萨市的数据中心,每天消耗约100万加仑的水用于冷却。而亚利桑那州正面临严重的干旱危机,科罗拉多河的水位已降至历史最低点。当地居民和环保组织对谷歌数据中心的用水提出了强烈抗议,认为这加剧了当地的水资源危机。

4.4 绿色计算的技术路径:液冷、芯片创新与能效优化

面对日益严峻的能源与环境挑战,AI产业正在积极探索绿色计算的技术路径。主要方向包括:

液冷技术

传统的数据中心采用风冷散热,能效比较低。液冷技术通过直接使用液体(如水或特殊冷却液)接触芯片进行散热,可以大幅提升冷却效率,降低能耗。据估算,液冷技术可将数据中心的能耗降低30%以上。

高能效AI芯片

下一代AI芯片正在朝着更高能效比的方向发展。例如,专用集成电路(ASIC)和存算一体(In-Memory Computing)等新架构,可以在保持性能的同时大幅降低功耗。英伟达的H200芯片相比上一代H100,能效比提升了约50%。

模型压缩与优化

通过模型剪枝、量化、蒸馏等技术,可以在保持模型性能的同时大幅减小模型规模,从而降低推理所需的算力和能耗。例如,8位量化可将模型大小和计算量减少约75%。

可再生能源直供

一些科技公司正在探索将数据中心直接建在可再生能源富集的地区,如冰岛的地热资源、北欧的水电和风电等,从而实现清洁能源的直接供应。微软甚至在探索将数据中心建在海底的可能性,利用海水进行自然冷却。

五、技术瓶颈与基础设施困境:制约AI发展的现实障碍

5.1 电网基础设施的老化与滞后

美国电力基础设施的老化问题,是制约AI算力扩张的首要障碍。高盛研报指出,美国电网的平均使用年限已达35至40年,远超其设计寿命。这些老旧的电网不仅效率低下,更容易出现故障,无法承受数据中心高密度、高负荷的用电需求。

电网升级的漫长周期

即便现在开始大规模投资电网升级,也难以在短期内见效。根据统计,美国新建电力项目的并网等待时间已延长至近5年。这意味着,从规划到真正投入使用,一个新的电力项目需要经历漫长的审批、建设和测试过程。在此期间,AI算力需求的增长速度远超电力供应的增长速度,供需缺口将持续扩大。

产能瓶颈:设备制造的限制

美国本土的电力设备产能仅能满足约40%的市场需求,大部分设备需要从海外进口。这不仅增加了成本,更带来了供应链安全的风险。特别是在中美关系紧张的背景下,关键电力设备的进口可能受到地缘政治因素的影响。

5.2 芯片封装技术的制约:CoWoS产能稀缺

AI芯片的性能提升,不仅取决于制程工艺的进步,更依赖于先进的封装技术。CoWoS(Chip-on-Wafer-on-Substrate)是台积电开发的一种先进封装技术,可以将多个芯片集成在同一封装内,大幅提升算力密度。然而,CoWoS的产能严重短缺,已成为制约AI芯片供应的关键瓶颈。

根据业内预测,台积电的CoWoS月产能到2025年底将达到7至8万片,到2026年可能进一步扩大,但仍远远无法满足市场需求。英伟达、AMD等芯片巨头都在争夺有限的CoWoS产能,导致供应链紧张。这种产能瓶颈不仅推高了芯片价格,更延缓了AI基础设施的建设进度。

5.3 数据中心建设的滞后:从规划到投运的时间差

数据中心的建设周期通常需要2至3年,从选址、设计、施工到最终投入运营,涉及大量的前期准备工作。然而,AI算力需求的增长速度远超数据中心的建设速度。根据能源咨询公司电网战略(GridStrategies)的预测,到2030年,美国的电力消费预计至少增长30%,而其中大部分增量来自数据中心。

数据中心建设的三大时间瓶颈

选址与审批:需要综合考虑电力供应、网络连接、环境影响等因素,审批流程复杂,通常需要6至12个月

基础设施建设:包括电力引入、冷却系统、网络布线等,施工周期约12至18个月

设备采购与调试:AI芯片、服务器、存储设备等关键设备的采购周期较长,且需要进行大量的调试和优化工作,通常需要6至12个月

5.4 人才短缺:AI与能源交叉领域的专业人才匮乏

AI算力基础设施的建设与运营,需要大量具备AI、能源、数据中心管理等交叉领域知识的专业人才。然而,这类人才目前极为稀缺。传统的电力工程师可能不熟悉AI算力的特殊需求,而AI工程师又可能缺乏对能源系统的深入了解。这种人才缺口,正在成为制约AI基础设施发展的隐性障碍。

六、全球竞争格局:中美在AI能源赛道的角力

6.1 美国:私营主导的自下而上路径

美国在AI算力基础设施的发展上,采取的是由私营企业主导、以商业愿景驱动的自下而上路径。Meta、微软、谷歌、亚马逊等科技巨头,凭借其雄厚的资本实力和技术优势,在AI算力与能源领域展开激烈竞争。这种竞争驱动的模式,虽然在技术创新和效率提升方面具有优势,但也带来了资源分散、重复建设和社会矛盾等问题。

美国模式的优势与挑战

优势

创新能力强,技术迭代快

资本充裕,投资规模大

市场机制灵活,资源配置效率高

挑战

基础设施老化,电网升级缓慢

社会矛盾加剧,"与民争电"问题突出

缺乏统一规划,资源重复投入

6.2 中国:国家战略引领的自上而下布局

与美国不同,中国在AI算力基础设施的发展上,采取的是由国家战略引领、自上而下统筹规划的路径。中国政府将"东数西算"工程作为国家级重大战略,通过在西部地区建设大型算力中心,充分利用当地丰富的可再生能源(如风电、光伏和水电),实现算力与能源的优化配置。

"东数西算"工程的核心逻辑

"东数西算"的核心思想,是将东部地区的海量数据传输到西部地区进行计算和存储,从而实现:

能源优化:西部地区拥有丰富的可再生能源,电力成本更低,且更清洁

区域平衡:促进西部地区经济发展,缩小东西部发展差距

战略安全:分散算力资源,降低单点故障风险,提升国家算力安全

截至2026年初,中国已在内蒙古、甘肃、宁夏、贵州等地建成或在建多个国家级算力枢纽节点。这些枢纽不仅配备了先进的AI算力设备,更与当地的风电、光伏等可再生能源项目深度结合,初步实现了绿色算力的规模化部署。

6.3 欧盟:强监管下的平衡发展

欧盟在AI算力基础设施的发展上,面临着独特的挑战。一方面,欧盟在AI技术和芯片制造方面相对落后于美国和中国;另一方面,欧盟在环境保护和数据隐私方面有着极为严格的监管要求。这使得欧盟在AI发展与可持续性之间,必须寻求更为精细的平衡。

欧盟正在推动"数字十年"计划(Digital Decade),目标是到2030年在AI、量子计算、半导体等领域实现技术突破,并确保所有数字基础设施实现碳中和。为此,欧盟不仅在投资AI研发,更在推动绿色数据中心标准的制定和实施。

6.4 日韩:核电回归与技术输出

日本和韩国在AI算力基础设施的发展上,面临着与美国类似的能源瓶颈问题。为了应对这一挑战,两国都在积极推动核电的回归。日本在福岛核事故后一度暂停了所有核电站的运营,但随着能源危机的加剧,日本政府正在重新审视核电政策。截至2026年,日本已重启了多座核电站,并计划进一步扩大核电装机容量。

韩国则在积极推动核电技术的输出。韩国斗山公司正在为美国的SMR项目提供关键设备,这标志着韩国在核能领域的技术实力得到了国际认可。同时,韩国也在探索将核电与AI算力中心结合的可能性,以应对国内日益增长的电力需求。

七、未来展望与政策建议:突破"能源墙"的可能路径

7.1 技术突破:从硬件到软件的全栈优化

突破"能源墙"的关键,在于实现从硬件到软件的全栈能效优化。这需要在多个层面同时发力:

芯片层面

开发更高能效比的AI芯片

探索新型计算架构(如存算一体、光子计算)

优化芯片封装技术,提升散热效率

系统层面

推广液冷技术,降低冷却能耗

优化电源管理,提升能源利用效率

采用模块化设计,实现灵活扩展

算法层面

模型压缩与量化技术

稀疏化与剪枝算法

知识蒸馏与迁移学习

7.2 能源转型:核能、可再生能源与储能的协同

实现AI算力的可持续发展,需要构建一个以核能为基荷、可再生能源为主体、储能为调节的多元化能源体系。这三者之间需要实现深度协同:

多元化能源体系的构建

核能:提供稳定的基荷电力,满足数据中心24小时不间断的电力需求

可再生能源:在条件允许的情况下,最大化利用风电、光伏等清洁能源,降低碳排放

储能:通过大规模储能系统,平滑可再生能源的波动,提升电网稳定性

智能调度:利用AI技术优化能源调度,实现供需的动态平衡

7.3 政策引导:平衡发展与公平的治理框架

政府在AI算力基础设施发展中应发挥关键的引导与监管作用。主要政策建议包括:

建立公平的电力定价机制

数据中心应承担与其用电量相匹配的基础设施建设成本,避免成本过度转嫁给普通居民。可以考虑实施阶梯电价或容量电价制度,让大用户承担更多责任。

强化环境监管与碳排放核算

建立统一的数据中心碳排放核算标准,要求科技公司定期披露其AI业务的真实碳足迹。对于未能达到减排目标的企业,应实施相应的惩罚措施。

加快电网升级与基础设施建设

政府应加大对电网升级的投资力度,简化新建电力项目的审批流程,缩短并网等待时间。同时,应鼓励采用分布式能源和微电网技术,提升电网的灵活性与韧性。

支持先进核能技术的研发与部署

政府应为SMR等先进核能技术的研发与商业化提供政策支持,包括简化审批流程、提供研发补贴、建立示范项目等。同时,应加强核安全监管,确保公众对核能的信心。

7.4 国际合作:构建全球AI能源治理体系

AI算力基础设施的能源挑战,是一个全球性问题,需要国际社会的共同努力。主要合作方向包括:

技术标准统一:推动全球数据中心能效标准的统一,建立可比较的碳排放核算体系

技术共享与转移:发达国家应向发展中国家提供先进的绿色计算技术和能源解决方案

资源优化配置:通过国际合作,实现算力资源与能源资源的全球优化配置,如利用赤道地区丰富的太阳能资源建设数据中心

危机应对机制:建立国际性的AI能源危机预警与应对机制,防止局部能源危机演变为全球性危机

结语:在算力与能源之间寻找平衡

2026年,全球AI产业正站在一个关键的十字路口。一方面,AI技术的进步为人类社会带来了前所未有的机遇,从医疗健康到气候变化,从教育到交通,AI正在深刻改变我们的生活方式。另一方面,支撑这一数字革命的物理基础——能源,正面临着日益严峻的挑战。"能源墙"不仅是一个技术问题,更是一个涉及经济、社会、环境与地缘政治的综合性挑战。

突破"能源墙",需要技术创新、政策引导和国际合作的多方协同。从短期来看,推广液冷技术、优化算法、提升芯片能效比等措施,可以在一定程度上缓解能源压力。从中长期来看,核能复兴、可再生能源规模化应用以及储能技术的突破,将为AI算力提供更加稳定、清洁的能源支撑。

然而,我们也必须认识到,技术进步并不能解决所有问题。在追求算力极限的同时,我们更需要反思:AI的发展是否应该有边界?我们是否应该为算力的增长付出无限的环境代价?如何在AI发展与社会公平、环境保护之间找到平衡?这些问题,不仅需要技术专家的回答,更需要全社会的深入思考与广泛讨论。

核心洞察

物理世界正在对数字世界发起反噬。AI越强大,耗电越狠——这不仅是一个技术现实,更是一个警示信号。在算力与能源的博弈中,我们需要的不仅是更强大的芯片和更高效的算法,更需要一种全新的发展理念:在追求技术进步的同时,守护我们共同的地球家园。

"能源墙"的挑战,或许正是促使我们重新审视AI发展路径、探索更加可持续未来的契机。

主要参考文献与数据来源

1. 新浪财经 (2026). 深度解读"下一代核能":当AI开始抢电,全世界重新押注核电

2. 华盛通 (2026). 2026展望| AI尽头是电力?"抢电大战"已经打响

3. 虎嗅网 (2026). AI在美国"与民争电",核电成了硅谷"全村的希望"

4. International Energy Agency (IEA). AI, Data Centers and Energy Demand

5. Goldman Sachs Research. Generational Growth: AI data centers and the coming US power demand surge

6. Morgan Stanley. U.S. Data Center Power Demand Analysis 2025-2028

7. Stanford AI Research Institute. AI Model Energy Consumption Database